Teoría de control

Antecedentes de las escuelas de Wikipedia

SOS Children han producido una selección de artículos de la Wikipedia para escuelas desde 2005. Para comparar obras de caridad de patrocinio este es el mejor vínculo de patrocinio .

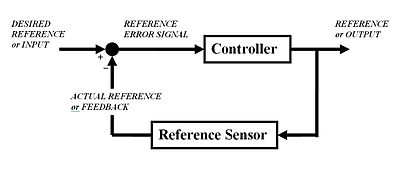

Teoría de control es una rama interdisciplinaria de la ingeniería y las matemáticas , que se ocupa del comportamiento de sistemas dinámicos. La salida deseada de un sistema se denomina la referencia. Cuando una o más variables de salida de un sistema deben seguir una cierta referencia en el tiempo, un controlador manipula las entradas a un sistema para obtener el efecto deseado en la salida del sistema.

| Wikibooks tiene un libro sobre el tema de: Sistemas de Control |

Visión de conjunto

La teoría de control es

- teoría, que se ocupa de influir en el comportamiento de sistemas dinámicos

- subcampo interdisciplinaria de la ciencia que se originó en la ingeniería y las matemáticas , y se desarrolló en el uso de las ciencias sociales, como la psicología , la sociología y la criminología.

Un ejemplo

Considere una de automóvil control de crucero, que es un dispositivo diseñado para mantener una velocidad constante del vehículo; la velocidad deseada o de referencia, proporcionado por el conductor. El sistema en este caso es el vehículo. La salida del sistema es la velocidad del vehículo, y la variable de control es la de motor la posición del acelerador del motor que influye salida de par.

Una forma sencilla de implementar el control de crucero es para bloquear la posición del acelerador cuando el conductor se involucra el control de crucero. Sin embargo, en terreno montañoso, el vehículo se ralentizará va cuesta arriba y acelerar a ir cuesta abajo. De hecho, cualquier parámetro diferente de lo que se supuso en tiempo de diseño se traducirá en un error proporcional en la velocidad de salida, incluyendo masa exacta del vehículo, la resistencia del viento, y la presión de los neumáticos. Este tipo de controlador se denomina controlador de bucle abierto porque no hay conexión directa entre la salida del sistema (el par motor) y las condiciones reales encontradas; es decir, el sistema no puede y no puede compensar fuerzas inesperadas.

En un sistema de control de bucle cerrado, un sensor monitoriza la salida (velocidad del vehículo) y alimenta los datos a un ordenador que ajusta continuamente la entrada de control (el acelerador) según sea necesario para mantener el error de control a un mínimo (para mantener la deseada velocidad). Comentarios sobre cómo el sistema está realizando realmente permite que el controlador (vehículo está en ordenador de a bordo) para compensar de forma dinámica para las perturbaciones en el sistema, tales como cambios en la pendiente de la velocidad respecto al suelo o el viento. Un sistema ideal de control de realimentación cancela todos los errores, mitigar eficazmente los efectos de todas las fuerzas que pueden o no pueden surgir durante el funcionamiento y la producción de una respuesta en el sistema que se adapta perfectamente a los deseos del usuario.

Historia

Aunque los sistemas de control de varios tipos se remontan a la antigüedad, un análisis más formal del campo comenzó con un análisis de la dinámica de la regulador centrífugo, llevado a cabo por el físico James Clerk Maxwell en 1868 titulado El Gobernadores. Esto describe y analiza el fenómeno de la "caza", en el que los rezagos en el sistema puede conducir a un exceso de compensación y el comportamiento inestable. Esto generó una oleada de interés en el tema, en la que la compañera de Maxwell Edward John Routh generalizar los resultados de Maxwell para la clase general de los sistemas lineales. Independientemente, Adolf Hurwitz analiza la estabilidad del sistema mediante ecuaciones diferenciales en 1877 . Este resultado se denomina Teorema de Routh-Hurwitz.

Una aplicación notable de control dinámico estaba en el área de los vuelos tripulados. Los hermanos Wright hicieron sus primeros vuelos de prueba con éxito en 17 de diciembre de 1903 y se distingue por su capacidad de controlar sus vuelos por períodos considerables (más que la capacidad de producir la elevación de un perfil aerodinámico, que era conocido). El control del avión era necesaria para la seguridad del vuelo.

Por la Segunda Guerra Mundial , la teoría de control era una parte importante de sistemas de control de fuego, los sistemas de orientación y de la electrónica . La carrera espacial dependía también de control de la nave espacial precisa. Sin embargo, la teoría de control también se registró un creciente uso en campos como la economía .

La gente en los sistemas y el control

Muchas figuras activas e históricas hacen importante contribución a la teoría de control, por ejemplo:

- Alexander Lyapunov (1857-1918) en la década de 1890 marca el inicio de teoría de la estabilidad.

- Harold S. Negro (1898-1983), inventó el amplificador de retroalimentación negativa en la década de 1930.

- Harry Nyquist (1889-1976), desarrolló el Criterio de estabilidad de Nyquist para sistemas de retroalimentación en la década de 1930.

- Richard Bellman (1920-1984), desarrollado programación dinámica desde la década de 1940.

- Norbert Wiener (1894-1964) acuñó el término Cibernética en la década de 1940.

- John R. Ragazzini (1912-1988) introdujo control digital y la transformada z en la década de 1950.

La teoría clásica de control: el controlador de lazo cerrado

Para evitar los problemas del controlador de bucle abierto, controlar introduce teoría retroalimentación. A-bucle cerrado controlador utiliza la retroalimentación para el control estados o salidas de una sistema dinámico. Su nombre proviene de la ruta de información en el sistema: las entradas del proceso (por ejemplo, tensión aplicada a una motor eléctrico) tener un efecto sobre las salidas del proceso (por ejemplo, la velocidad o el par del motor), que se mide con sensores y procesados por el controlador; el resultado (la señal de control) se utiliza como insumo para el proceso, cerrando el ciclo.

Controladores de bucle cerrado tienen las siguientes ventajas sobre las controladores de lazo abierto:

- rechazo de perturbaciones (tales como la fricción no medida en un motor)

- rendimiento garantizado, incluso con incertidumbres del modelo, cuando la estructura del modelo no coincide perfectamente con el proceso real y los parámetros del modelo no son exactas

- procesos inestables pueden ser estabilizadas

- reducción de la sensibilidad a las variaciones de los parámetros

- rendimiento de seguimiento mejorado referencia

En algunos sistemas de circuito cerrado y control de bucle abierto se utilizan simultáneamente. En tales sistemas, el control de bucle abierto se denomina anticipativo y sirve para mejorar aún más el rendimiento de rastreo de referencia.

Una arquitectura de controlador de bucle cerrado común es la Controlador PID.

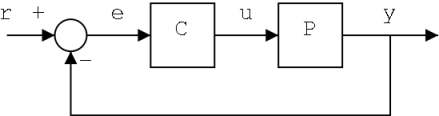

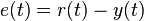

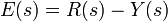

La salida del sistema de y (t) se alimenta de nuevo a la valor de referencia r (t), a través de una medición del sensor. El controlador C toma entonces el error e (diferencia) entre la referencia y la salida para cambiar las entradas u para el sistema bajo control P. Esto se muestra en la figura. Este tipo de controlador es un controlador o controlador de retroalimentación de bucle cerrado.

Esto se conoce como un sistema de control de una sola entrada-salida (SISO); MIMO (es decir, múltiples entradas múltiples salidas) sistemas, con más de una entrada / salida, son comunes. En tales casos variables se representan a través vectores en lugar de sencillo valores escalares. Para algunos sistemas de parámetros distribuidos los vectores pueden ser infinite- dimensionales (típicamente funciones).

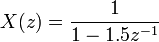

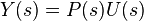

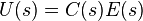

Si asumimos que el controlador C y la planta de P son lineal y el tiempo-invariante (es decir: los elementos de su función de transferencia C (s) y P (s) no dependen de tiempo), los sistemas anteriores se pueden analizar utilizando la Transformada de Laplace de las variables. Esto le da a las siguientes relaciones:

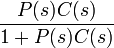

Despejando Y (s) en términos de R (s) da:

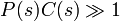

El término  se conoce como la función de transferencia del sistema. El numerador es la ganancia directa de R a y, y el denominador es uno más la ganancia de bucle del bucle de retroalimentación. Si

se conoce como la función de transferencia del sistema. El numerador es la ganancia directa de R a y, y el denominador es uno más la ganancia de bucle del bucle de retroalimentación. Si  , Es decir, tiene una gran norma con cada valor de s, entonces Y (s) es aproximadamente igual a R (s). Esto significa simplemente asignar la referencia controla la salida.

, Es decir, tiene una gran norma con cada valor de s, entonces Y (s) es aproximadamente igual a R (s). Esto significa simplemente asignar la referencia controla la salida.

Temas en la teoría de control

Estabilidad

Estabilidad (en la teoría de control) a menudo significa que para cualquier entrada acotada durante cualquier cantidad de tiempo, la salida también será limitada. Esto se conoce como BIBO estabilidad (ver también Lyapunov estabilidad). Si un sistema es BIBO estable, la salida no puede "volar" (es decir, convertirse en infinito) si la entrada sigue siendo finito. Matemáticamente, esto significa que para un sistema lineal causal sea estable todo el polos de su función de transferencia debe cumplir algunos criterios en función de si se utiliza un análisis continuo o discreto tiempo:

- En tiempo continuo, la Transformada de Laplace se utiliza para obtener la función de transferencia. Un sistema es estable si los polos de esta función de transferencia se encuentran estrictamente en el medio cerrado izquierda del plano complejo . es decir, la parte real de todos los polos es menor que cero).

Oregón

- En tiempo discreto la Z-transformar se utiliza. Un sistema es estable si los polos de esta función de transferencia se encuentran dentro de la strictyly círculo unidad. es decir, la magnitud de los polos es menor que uno).

Cuando las condiciones apropiadas anteriormente son satisfechos un sistema se dice que es asintóticamente estable: las variables de un sistema de control asintóticamente estable siempre disminuyen de su valor inicial y no muestran oscilaciones permanentes. Oscilaciones permanentes ocurrir cuando un polo tiene una parte real exactamente igual a cero (en el caso de tiempo continuo) o un módulo igual a uno (en el caso de tiempo discreto). Si una respuesta del sistema simplemente estable ni se desintegra ni crece con el tiempo, y no tiene oscilaciones, es marginalmente estable: en este caso la función de transferencia del sistema tiene polos no repetidos en origen del plano complejo (es decir, su componente real y complejo es cero en el caso de tiempo continuo). Oscilaciones están presentes cuando polos con parte real igual a cero tienen una parte imaginaria no es igual a cero.

Las diferencias entre los dos casos no son una contradicción. La transformada de Laplace se encuentra en las coordenadas cartesianas y la transformada Z es en coordenadas circulares , y se puede demostrar que

- la parte negativa-real en el dominio de Laplace puede mapear en el interior del círculo unidad

- la parte positiva-real en el dominio de Laplace puede mapear en el exterior del círculo unidad

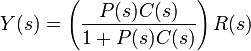

Si un sistema en cuestión tiene una respuesta de impulso de

entonces la Z-transformar (ver este ejemplo), está dada por

que tiene un poste en  (Cero parte imaginaria). Este sistema es BIBO (asintóticamente) estable desde el polo está dentro del círculo unitario.

(Cero parte imaginaria). Este sistema es BIBO (asintóticamente) estable desde el polo está dentro del círculo unitario.

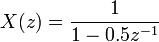

Sin embargo, si la respuesta de impulso era

entonces la transformada Z es

que tiene un polo en  y no es estable BIBO desde el polo tiene un módulo estrictamente mayor que uno.

y no es estable BIBO desde el polo tiene un módulo estrictamente mayor que uno.

Existen numerosas herramientas para el análisis de los polos de un sistema. Estos incluyen sistemas gráficos como la lugar de las raíces, Diagramas de Bode o la Diagramas de Nyquist.

Controlabilidad y observabilidad

Controlabilidad y observabilidad son temas principales en el análisis de un sistema antes de decidir la mejor estrategia de control que se deben aplicar, o si es incluso posible controlar o estabilizar el sistema. Controlabilidad se relaciona con la posibilidad de forzar al sistema a un estado en particular mediante el uso de una señal de control apropiada. Si un estado no es controlable, entonces no hay señal alguna vez será capaz de controlar el estado. Si un estado no es controlable, pero su dinámica son estables, entonces el estado se denomina estabilizable. Observabilidad vez se relaciona con la posibilidad de "observar", a través de medidas de salida, el estado de un sistema. Si un estado no es observable, el controlador nunca será capaz de determinar el comportamiento de un estado no observable y por lo tanto no se puede utilizar para estabilizar el sistema. Sin embargo, similar a la condición stabilizability anteriormente, si no se puede observar un estado todavía podría ser detectable.

Desde un punto de vista geométrico, mirando a los estados de cada variable del sistema a ser controlado, cada estado "malo" de estas variables debe ser controlable y observable para asegurar un buen comportamiento en el sistema de bucle cerrado. Es decir, si uno de los valores propios del sistema no es tanto controlable y observable, esta parte de la dinámica se mantendrá intacta en el sistema de circuito cerrado. Si un valor propio como no es estable, la dinámica de este valor propio estará presente en el sistema de bucle cerrado que por lo tanto será inestable. Polos no observables no están presentes en la realización función de transferencia de una representación de espacio de estado, por lo que a veces este último se prefiere en el análisis de sistemas dinámicos.

Las soluciones a los problemas del sistema incontrolable o inobservable incluyen la adición de actuadores y sensores.

Especificaciones de control

Varios diferentes estrategias de control se han diseñado en los últimos años. Estos varían desde los muy generales ( Controlador PID), a los demás dedicado a clases muy particulares de los sistemas (especialmente robótica o aviones de control de crucero).

Un problema de control puede tener varias especificaciones. Estabilidad, por supuesto, está siempre presente: el controlador debe garantizar que el sistema de circuito cerrado es estable, independientemente de la estabilidad en lazo abierto. Una mala elección de controlador puede incluso empeorar la estabilidad del sistema en lazo abierto, el cual debe ser evitado normalmente. A veces se desea obtener dinámica particular en el bucle cerrado: es decir, que los polos tienen ![Re [\ lambda] <- \ overline {\ lambda}](../../images/190/19048.png) , Donde

, Donde  es un valor fijo estrictamente mayor que cero, en lugar de simplemente pedir que

es un valor fijo estrictamente mayor que cero, en lugar de simplemente pedir que ![Re [\ lambda] <0](../../images/190/19050.png) .

.

Otra especificación típica es el rechazo a una perturbación escalón; incluyendo una integrador en la cadena de bucle abierto (es decir, directamente antes de que el sistema bajo control) logra esto fácilmente. Otras clases de perturbaciones necesitan diferentes tipos de subsistemas que deben incluirse.

Otras especificaciones teóricas de control "clásicos" consideran que el tiempo de respuesta del sistema de circuito cerrado: cuenta con el tiempo de subida (el tiempo que necesita el sistema de control para alcanzar el valor deseado después de una perturbación), pico rebasamiento (el valor más alto alcanzado por la respuesta antes de llegar al valor deseado) y otros ( tiempo de establecimiento, de un cuarto de la decadencia). Las especificaciones de dominio de frecuencia suelen estar relacionados con robustez (ver después).

Evaluaciones de desempeño modernos utilizan alguna variación de error de seguimiento integrado (IAE, ISA, CQI).

Identificación del modelo y robustez

Un sistema de control siempre debe tener alguna propiedad robustez. La controlador robusto es tal que sus propiedades no cambian mucho si se aplica a un sistema ligeramente diferente de la matemático utilizado para su síntesis. Esta especificación es importante: hay un sistema físico real verdaderamente se comporta como la serie de ecuaciones diferenciales utilizados para representar matemáticamente. Normalmente, un modelo matemático sencillo se elige con el fin de simplificar los cálculos, de lo contrario la verdadera dinámica del sistema pueden ser tan complicado que un modelo completo es imposible.

Identificación del sistema

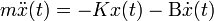

El proceso de determinación de las ecuaciones que gobiernan la dinámica del modelo se llama identificación del sistema. Esto se puede hacer fuera de línea: por ejemplo, la ejecución de una serie de medidas a partir del cual se calcula un modelo matemático aproximado, por lo general su función de transferencia o matriz. Tal identificación de la salida, sin embargo, no puede tener en cuenta la dinámica no observables. A veces, el modelo se construye empezando directamente de ecuaciones físicas conocidos: por ejemplo, en el caso de una sistema masa-resorte-amortiguador sabemos que  . Aun suponiendo que un modelo de "completo" se utiliza en el diseño del controlador, todos los parámetros incluidos en estas ecuaciones (llamados "parámetros nominales") nunca se sabe con absoluta precisión; el sistema de control tendrá que comportarse correctamente incluso cuando se conecta al sistema de física con los verdaderos valores de los parámetros de distancia de nominal.

. Aun suponiendo que un modelo de "completo" se utiliza en el diseño del controlador, todos los parámetros incluidos en estas ecuaciones (llamados "parámetros nominales") nunca se sabe con absoluta precisión; el sistema de control tendrá que comportarse correctamente incluso cuando se conecta al sistema de física con los verdaderos valores de los parámetros de distancia de nominal.

Algunas técnicas avanzadas de control incluyen un proceso de identificación "en línea" (ver más adelante). Los parámetros del modelo se calculan ("identificado"), mientras que el propio controlador se está ejecutando: de esta manera, si una variación drástica de los parámetros sobreviene (por ejemplo, si el brazo del robot libera un peso), el controlador se ajustará en consecuencia con el fin de asegurar el rendimiento correcto.

Análisis

Análisis de la robustez de un sistema de control SISO se puede realizar en el dominio de la frecuencia, teniendo en cuenta la función de transferencia del sistema y el uso de Nyquist y Diagramas de Bode. Los temas incluyen la ganancia y la fase de margen y el margen de amplitud. Para MIMO y, en los sistemas generales de control, más complicados hay que considerar los resultados teóricos ideados para cada técnica de control (véase la sección siguiente): es decir, si son necesarias particulares cualidades de robustez, el ingeniero debe cambiar su atención a una técnica de control de incluirlos en sus propiedades.

Restricciones

Una cuestión robustez particular es el requisito para un sistema de control para llevar a cabo adecuadamente en presencia de restricciones de entrada y estatales. En el mundo físico cada señal es limitada. Podría suceder que un controlador enviará señales de control que no se pueden seguir por el sistema de física: por ejemplo, tratando de girar una válvula a una velocidad excesiva. Esto puede producir un comportamiento no deseado del sistema de circuito cerrado, o incluso romper actuadores u otros subsistemas. Técnicas de control específicos están disponibles para resolver el problema: modelo de control predictivo (véase más adelante), y anti-viento de sistemas. Este último consiste en un bloque de control adicional que asegura que la señal de control nunca excede de un umbral dado.

Estrategias de control principales

Cada sistema de control debe garantizar primero la estabilidad del comportamiento de bucle cerrado. Para sistemas lineales, esto se puede obtener colocando directamente los polos. Sistemas de control no lineales utilizan teorías específicas (normalmente basados en Teoría de Aleksandr Lyapunov) para garantizar la estabilidad sin tener en cuenta la dinámica interna del sistema. La posibilidad de cumplir las diferentes especificaciones varía desde el modelo considerado y la estrategia de control elegida. Aqui una lista resumida de las principales técnicas de control:

Control Clásico

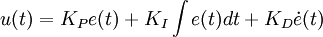

La Controlador PID es probablemente el diseño de control de retroalimentación más utilizado, siendo la más simple. "PID" significa-Proporcional Integral Derivativo, en referencia a los tres términos que operan en la señal de error para producir una señal de control. Si u (t) es la señal de control enviada al sistema, y (t) es la salida medida y r (t) es la salida deseada, y el error de seguimiento  , Un controlador PID tiene la forma general

, Un controlador PID tiene la forma general

La dinámica de bucle cerrado deseado se obtiene mediante el ajuste de los tres parámetros  ,

,  y

y  , A menudo de forma iterativa por "ajuste" y sin conocimiento específico de un modelo de planta. Estabilidad a menudo se puede asegurar usando sólo el término proporcional. El término integral permite el rechazo de una perturbación escalón (a menudo una especificación sorprendente en control de procesos). El término derivado se usa para proporcionar amortiguación o conformación de la respuesta. Controladores PID son la clase más bien establecido de sistemas de control: Sin embargo, no se pueden utilizar en varios casos más complicados, especialmente si se consideran los sistemas MIMO.

, A menudo de forma iterativa por "ajuste" y sin conocimiento específico de un modelo de planta. Estabilidad a menudo se puede asegurar usando sólo el término proporcional. El término integral permite el rechazo de una perturbación escalón (a menudo una especificación sorprendente en control de procesos). El término derivado se usa para proporcionar amortiguación o conformación de la respuesta. Controladores PID son la clase más bien establecido de sistemas de control: Sin embargo, no se pueden utilizar en varios casos más complicados, especialmente si se consideran los sistemas MIMO.

Control lineal

Para los sistemas MIMO, la colocación de polo se puede realizar matemáticamente utilizando una Espacio de estados del sistema en lazo abierto y el cálculo de una matriz de realimentación asignación de polos en las posiciones deseadas. En sistemas complicados esto puede requerir capacidades de cálculo con ayuda de computadora, y no siempre se puede garantizar robustez. Además, todos los estados del sistema que no están en observadores medidos y tan general deben ser incluidos e incorporados en el diseño de la colocación del poste.

De control no lineal

Procesos en industrias como robótica y la industria aeroespacial suelen tener fuertes dinámica no lineal. En la teoría de control a veces es posible linealizar estas clases de sistemas y aplicar técnicas lineales: pero en muchos casos puede ser necesario diseñar de las teorías de arañazos que permiten el control de sistemas no lineales. Estos, por ejemplo, linealización por realimentación, backstepping, control por modo deslizante, control de linealización trayectoria normalmente se aprovechan de los resultados basada en Teoría. De Lyapunov geometría diferencial ha sido ampliamente utilizado como una herramienta para la generalización de los conceptos de control lineales bien conocidos para el caso no lineal, así como mostrar las sutilezas que hacen que sea un problema más difícil.

El control óptimo

El control óptimo es una técnica de control particular en el que la señal de control optimiza una cierta "índice de costes": por ejemplo, en el caso de un satélite, los empujes de chorro necesarios para llevar a trayectoria deseada que consumir la menor cantidad de combustible. Dos métodos de diseño de control óptima se han usado ampliamente en aplicaciones industriales, ya que se ha demostrado que pueden garantizar la estabilidad de bucle cerrado. Estos son Modelo de Control predictivo (MPC) y Control lineal cuadrático gaussiano (LQG). El primero puede tomar más explícitamente en cuenta las limitaciones de las señales en el sistema, que es una característica importante en muchos procesos industriales. Sin embargo, la estructura de "control óptimo" en MPC es sólo un medio para lograr tal resultado, ya que no optimizar un cierto índice de rendimiento del sistema de control de bucle cerrado. Junto con los controladores PID, sistemas MPC son la técnica de control más utilizado en control de procesos.

Control adaptativo

El control adaptativo utiliza la identificación en línea de los parámetros del proceso, o la modificación de las ganancias del controlador, obteniendo con ello fuertes propiedades de robustez. Controles adaptativos se aplicaron por primera vez en el industria aeroespacial en el De 1950, y han encontrado un éxito particular en ese campo.

Control inteligente

Uso inteligente de control diferentes computación AI se acerca como redes neuronales, Probabilidad bayesiana, lógica difusa, aprendizaje automático, computación evolutiva y los algoritmos genéticos para controlar una sistema dinámico

El control jerárquico

Un sistema de control jerárquico es una forma de Sistema de control en el que un conjunto de dispositivos y el software de gobierno está dispuesto en una jerárquica árbol. Cuando los enlaces del árbol son implementadas por un red informática, a continuación, que el sistema de control jerárquico es también una forma de Sistema de control de red.

Literatura

- Christopher Kilian (2005). Tecnología de control moderna. Thompson Delmar Learning. ISBN 1-4018-5806-6.

- Análisis Vannevar Bush (1929). Circuito Operacional. John Wiley and Sons, Inc ..

- Robert F. Stengel (1994). Control Óptimo y estimación. Dover Publications. ISBN 0-486-68200-5, ISBN-13: 978-0-486-68200-6.

- Franklin et al. (2002). Evaluación de control de motores (4 ed.). Nueva Jersey: Prentice Hall. ISBN 0-13-032393-4.

- Joseph L. Hellerstein, Dawn M. Tilbury, y Sujay Parekh (2004). Evaluación de Control de Sistemas Informáticos. John Wiley and Sons. ISBN 0-47-126637-X, ISBN-13: 978-0-471-26637-2.

- Sistema dinámico y Anthony J. Pritchard (2005) Sistemas de Matemáticas Teoría I -. Modelado, Análisis Espacial Estado, estabilidad y robustez. Springer. ISBN 0-978-3-540-44125-0.

- Sontag, Eduardo (1998) Teoría de Control Matemática:. Sistemas dimensionales finitos deterministas. Segunda Edicion. Springer. ISBN 0-387-984895.

![\ x [n] = 0,5 ^ n u [n]](../../images/190/19042.png)

![\ x [n] = 1,5 ^ n u [n]](../../images/190/19045.png)