Teoria de controle

Fundo para as escolas Wikipédia

Crianças SOS têm produzido uma seleção de artigos da Wikipedia para escolas desde 2005. Para comparar instituições de caridade de patrocínio esta é a melhor ligação de patrocínio .

Teoria de controle é um ramo interdisciplinar de engenharia e matemática , que lida com o comportamento de sistemas dinâmicos. A saída desejada de um sistema é chamado de referência. Quando uma ou mais variáveis de um sistema de saída precisa seguir uma certa referência ao longo do tempo, uma controlador manipula as entradas de um sistema para se obter o efeito desejado na saída do sistema.

| Wikibooks tem um livro sobre o tema de: Sistemas de Controle |

Visão global

Teoria de controle é

- teoria, que lida com a influenciar o comportamento dos sistemas dinâmicos

- subcampo interdisciplinar da ciência que se originou na engenharia e matemática , e evoluiu para o uso pelas ciências sociais, como psicologia , sociologia e criminologia.

Um exemplo

Considere um do automóvel controle de cruzeiro, que é um dispositivo projetado para manter uma velocidade constante do veículo; a velocidade desejada ou referência, fornecido pelo motorista. O sistema, neste caso, é o veículo. O resultado deste sistema é a velocidade do veículo, e a variável de controlo é do motor posição do acelerador do motor que influencia saída de torque.

Uma maneira simples de implementar o controle de cruzeiro é para bloquear a posição do acelerador quando o motorista engata controle de cruzeiro. No entanto, em um terreno montanhoso, o veículo vai abrandar indo para cima e acelerar indo ladeira abaixo. Na verdade, qualquer parâmetro diferente do que foi assumido no momento da estruturação se traduzirá em um erro proporcional na velocidade de saída, incluindo a massa exata do veículo, a resistência do vento e pressão dos pneus. Este tipo de controlador é chamado de controlador de circuito aberto porque não há nenhuma conexão direta entre a saída do sistema (o torque do motor) e as condições reais encontradas; ou seja, o sistema não faz e não pode compensar as forças inesperadas.

Em um sistema de controlo de circuito fechado, um sensor monitoriza a saída (velocidade do veículo) e alimenta os dados a um computador que ajusta continuamente a entrada de controlo (o regulador de pressão), se necessário para manter o erro de controlo para um mínimo (para manter o desejado velocidade). Comentários sobre como o sistema é realmente executar permite que o controlador (veículo está no computador de bordo) para compensar dinamicamente para perturbações no sistema, tais como alterações na inclinação da velocidade no solo ou vento. Um sistema de controlo de retorno ideal anula todos os erros, atenuar de forma eficaz os efeitos de quaisquer forças que podem ou não podem ocorrer durante a operação e que produzem uma resposta no sistema que combina perfeitamente com a vontade do utilizador.

História

Embora os sistemas de vários tipos de controlo remontam à antiguidade, uma análise mais formal do campo começou com uma análise da dinâmica da governador centrífuga, conduzida pelo físico James Clerk Maxwell em 1868 , intitulado On Governadores. Este descrito e analisado o fenômeno da "caça", em que fica no sistema pode conduzir a uma sobrecompensação e comportamento instável. Isso gerou uma onda de interesse no tema, durante a qual colega de Maxwell Edward John Routh generalizada os resultados de Maxwell para a classe geral de sistemas lineares. De forma independente, Adolf Hurwitz analisada a estabilidade do sistema usando equações diferenciais em 1877 . Este resultado é chamado o Routh-Hurwitz teorema.

Um aplicativo notável de controle dinâmico estava na área de voo tripulado. Os irmãos Wright fez seus primeiros vôos bem sucedidos no teste 17 de dezembro de 1903 e foram distinguidos pela sua capacidade de controlar os seus voos para períodos substanciais (mais do que a capacidade de produzir sustentação de um aerofólio, que era conhecido). O controlo do avião era necessário para um voo seguro.

Por II Guerra Mundial , teoria de controle foi uma parte importante da sistemas de controle de fogo, sistemas de orientação e eletrônica . A corrida espacial também dependia de controle espaçonave precisa. No entanto, a teoria de controle também viu uma crescente utilização em áreas como a economia .

Pessoas em sistemas e controle

Muitas figuras ativos e históricos feitos contribuição significativa para controlar teoria, por exemplo:

- Alexander Lyapunov (1857-1918) na década de 1890 marca o início de teoria de estabilidade.

- Harold S. Black (1898-1983), inventou o amplificador de feedback negativo na década de 1930.

- Harry Nyquist (1889-1976), desenvolveu o Critério de estabilidade de Nyquist para sistemas de feedback na década de 1930.

- Richard Bellman (1920-1984), desenvolvido programação dinâmica desde os anos 1940.

- Norbert Wiener (1894-1964) cunhou o termo Cibernética na década de 1940.

- John R. Ragazzini (1912-1988) introduziu controle digital e da z-transform na década de 1950.

Teoria de controle clássico: o controlador de circuito fechado

Para evitar os problemas de o controlador de ciclo aberto, controlar introduz teoria feedback. Um de circuito fechado controlador usa feedback para controle estados ou saídas de um sistema dinâmico. Seu nome vem do caminho de informações no sistema: entradas do processo (por exemplo, tensão aplicada a um motor eléctrico) têm um efeito sobre as saídas do processo (por exemplo, a velocidade ou o binário do motor), a qual é medida com sensores e processados pelo controlador; o resultado (o sinal de controlo) é usado como entrada para o processo, fechando o circuito.

Controladores de circuito fechado tem as seguintes vantagens sobre controladores de circuito aberto:

- rejeição de distúrbios (tal como atrito desmedida em um motor)

- desempenho garantido, mesmo com incertezas do modelo, quando a estrutura do modelo não corresponder perfeitamente o processo real e os parâmetros do modelo não são exatos

- processos instáveis podem ser estabilizadas

- redução da sensibilidade a variações dos parâmetros

- desempenho de rastreamento melhorado referência

Em alguns sistemas, em circuito fechado e controle de ciclo aberto são usados simultaneamente. Em tais sistemas, o controlo de ciclo aberto é denominado feedforward e serve para melhorar ainda mais o desempenho de rastreamento de referência.

Um controlador de arquitetura de circuito fechado comum é o Controlador PID.

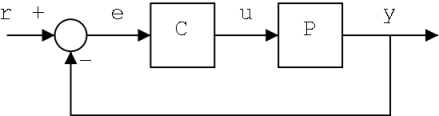

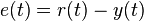

A saída do sistema de y (t) é alimentado de volta ao valor de referência r (t), por meio de um sensor de medição. O controlador C, em seguida, leva o e erro (diferença) entre a referência ea saída para mudar as entradas u ao sistema sob controle P. Isto é mostrado na figura. Este tipo de controlador é um controlador ou feedback do controlador de circuito fechado.

Isso é chamado de um sistema de controle de entrada única-saída única (SISO); MIMO (ou seja, Multi-Input-Multi-Output) de sistemas, com mais de um input / output, são comuns. Em tais casos as variáveis são representados através vetores em vez de simples valores escalares. Para alguns sistemas de parâmetros distribuídos os vectores podem ser infinite- dimensionais (tipicamente funções).

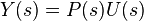

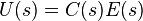

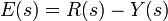

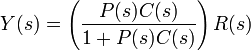

Se assumirmos o controlador C e P são a planta linear e invariante no tempo (ou seja: elementos de sua função de transferência C (s) e P (s) não depende do tempo), os sistemas acima podem ser analisados usando o Laplace sobre as variáveis. Isto dá as seguintes relações:

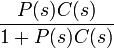

Resolvendo para Y (s) em termos de I (s) dá:

O termo  é referido como a função de transferência do sistema. O numerador é o ganho para a frente a partir de r para y, eo denominador é um mais o ganho da malha do ciclo de feedback. Se

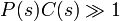

é referido como a função de transferência do sistema. O numerador é o ganho para a frente a partir de r para y, eo denominador é um mais o ganho da malha do ciclo de feedback. Se  , Ou seja, tem uma grande norma com cada valor de S, então o substituinte Y (s) é aproximadamente igual a R (s). Isto significa simplesmente definindo a referência controla a saída.

, Ou seja, tem uma grande norma com cada valor de S, então o substituinte Y (s) é aproximadamente igual a R (s). Isto significa simplesmente definindo a referência controla a saída.

Tópicos em teoria de controle

Estabilidade

Estabilidade (em teoria de controle), muitas vezes significa que para qualquer entrada limitada sobre qualquer quantidade de tempo, a saída irá também ser delimitada. Isto é conhecido como Estabilidade BIBO (ver também Estabilidade de Lyapunov). Se um sistema é BIBO estável, em seguida, a saída não pode "explodir" (ou seja, tornar-se infinito) se a entrada permanece finito. Matematicamente, isto significa que, para um sistema linear de causalidade para ser estável durante todo o vértices do seu função de transferência deve satisfazer alguns critérios, dependendo se uma análise de tempo contínuo ou discreto é usado:

- Em tempo contínuo, o Transformada de Laplace é utilizado para obter a função de transferência. Um sistema é estável se os postes de esta função de transferência ficam estritamente na metade esquerda fechada do plano complexo . ou seja, a parte real de todos os pólos é menor que zero).

OR

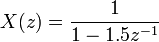

- Em tempo discreto o Z-transformação é usado. Um sistema é estável se os pólos de esta função de transferência se encontram no interior do strictyly círculo unitário. ou seja, a magnitude dos pólos é inferior a um).

Quando as condições apropriadas acima são satisfeitos de um sistema está a ser dito assintoticamente estável: as variáveis de um sistema de controle assintoticamente estável sempre diminuir a partir de seu valor inicial e não mostram oscilações permanentes. Oscilações permanentes ocorrem quando um poste tem uma parte real exactamente igual a zero (no caso de tempo contínuo) ou um módulo de elasticidade igual a um (no caso de tempo discreto). Se uma resposta do sistema simplesmente estável nem deteriora nem cresce ao longo do tempo, e não tem oscilações, é marginalmente estável: neste caso, a função de transferência do sistema tem pólos não repetido na origem do plano complexo (ou seja, o seu componente real e complexo é zero no caso de tempo contínuo). Oscilações estão presentes quando pólos com parte real igual a zero tem uma parte imaginária não é igual a zero.

As diferenças entre os dois casos não são uma contradição. A transformada de Laplace é em coordenadas cartesianas eo Z-transform é em coordenadas circulares , e se puder ser demonstrado que

- a parte negativa-real no domínio de Laplace pode ser mapeado para o interior do círculo unitário

- a parte positiva-real no domínio de Laplace pode ser mapeado para o exterior do círculo unitário

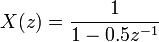

Se um sistema em questão tem um resposta ao impulso de

então o Z-transform (veja neste exemplo), é dada pela

que tem um pólo em  (Zero parte imaginária). Este sistema é BIBO (asymptotically) estável desde o pólo está dentro do círculo unitário.

(Zero parte imaginária). Este sistema é BIBO (asymptotically) estável desde o pólo está dentro do círculo unitário.

No entanto, se a resposta ao impulso era

em seguida, a transformada z é

que tem um pólo em  e não é BIBO estável desde o poste tem um módulo estritamente maior que um.

e não é BIBO estável desde o poste tem um módulo estritamente maior que um.

Existem numerosas ferramentas para a análise dos pólos de um sistema. Estes incluem sistemas gráficos como o lugar das raízes, Diagramas de Bode ou o Parcelas de Nyquist.

Controlabilidade e observabilidade

Controlabilidade e observabilidade são questões principais na análise de um sistema antes de decidir a melhor estratégia de controlo a serem aplicados, ou se é mesmo possível para controlar ou estabilizar o sistema. Controlabilidade está relacionada com a possibilidade de forçar o sistema para um estado particular, utilizando um sinal de controlo apropriado. Se um Estado não é controlável, então nenhum sinal nunca vai ser capaz de controlar o estado. Se um Estado não é controlável, mas a sua dinâmica são estáveis, então o estado que é denominado estabilizável. Observabilidade vez está relacionada com a possibilidade de "observação", através de medições de saída, o estado de um sistema. Se um estado não é observável, o controlador nunca será capaz de determinar o comportamento de um estado não observável e, portanto, não pode usá-lo para estabilizar o sistema. No entanto, semelhante à condição estabilizabilidade acima, se um estado não pode ser observado pode ainda ser detectável.

De um ponto de vista geométrico, olhando para os estados de cada variável do sistema a ser controlada, todos os estados "mau" destas variáveis devem ser controlável e observável para garantir um bom comportamento no sistema de circuito fechado. Ou seja, se um dos valores próprios do sistema não é tanto controlável e observável, esta parte da dinâmica permanecerá intocado no sistema de circuito fechado. Se tal valor próprio não é estável, a dinâmica deste valor próprio estará presente no sistema de circuito fechado, por conseguinte, que será instável. Pólos não observáveis não estão presentes na realização função de transferência de um espaço de estados, razão pela qual, por vezes, este último é o preferido em análise de sistemas dinâmicos.

Soluções para problemas de sistema incontrolável ou não observáveis incluem a adição de atuadores e sensores.

Especificações de controlo

Várias estratégias de controle diferentes foram criadas nos últimos anos. Estes variam desde as extremamente gerais ( PID controlador), para os outros dedicado a muito classes particulares de sistemas (especialmente robótica ou aeronaves controle de cruzeiro).

Um problema de controle pode ter várias especificações. Estabilidade, é claro, é sempre presente: o controlador tem que assegurar que o sistema de circuito fechado é estável, independentemente da estabilidade de ciclo aberto. Uma má escolha de controlador pode até mesmo piorar a estabilidade do sistema em malha aberta, o que deve normalmente ser evitado. Às vezes, seria desejável para obter dinâmica particular no circuito fechado: isto é, que tem os pólos ![Re [\ lambda] <- \ overline {\ lambda}](../../images/190/19048.png) , Onde

, Onde  é um valor fixo estritamente maior que zero, em vez de simplesmente fazer essa

é um valor fixo estritamente maior que zero, em vez de simplesmente fazer essa ![Re [\ lambda] <0](../../images/190/19050.png) .

.

Outra especificação típica é a rejeição de uma perturbação passo; incluindo um integrador da cadeia de circuito aberto (ou seja, diretamente antes que o sistema sob controle) atinge facilmente isso. Outras classes de perturbações necessitam de diferentes tipos de sub-sistemas para ser incluído.

Outras especificações teoria controle "clássicos" considerar o tempo de resposta do sistema de circuito fechado: estas incluem o tempo de subida (o tempo necessário para que o sistema de controlo para atingir o valor desejado, após uma perturbação), pico overshoot (o valor mais alto atingido pela resposta antes de atingir o valor desejado) e outros ( Tempo de deposição, quartas-de-decadência). Especificações do domínio da frequência estão normalmente relacionados com robustez (ver depois).

Avaliações de desempenho modernos usam alguma variação de erro de rastreamento integrado (IAE, ISA, CQI).

De identificação do modelo e robustez

Um sistema de controle deve sempre ter alguma propriedade robustez. A controlador robusto é tal que as suas propriedades não mudam muito se aplicado a um sistema ligeiramente diferente do matemático utilizado para a sua síntese. Esta especificação é importante: nenhum sistema físico real realmente se comporta como a série de equações diferenciais usados para representá-la matematicamente. Tipicamente um modelo matemático simples é escolhido de modo a simplificar os cálculos, caso contrário, a verdadeira dinâmica do sistema pode ser tão complicado que um modelo completo é impossível.

Sistema de identificação

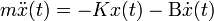

O processo de determinação das equações que governam a dinâmica do modelo é chamada identificação do sistema. Isto pode ser feito fora da linha de: por exemplo, a execução de uma série de medidas de partida para calcular um modelo matemático aproximada, geralmente a sua função de transferência ou matriz. Essa identificação a partir da saída, no entanto, não pode ter em conta a dinâmica não observáveis. Por vezes, o modelo é feito directamente a partir de equações físicas conhecidas: por exemplo, no caso de um sistema massa-mola-amortecedor sabemos que  . Mesmo admitindo que um modelo "completa" é utilizado na concepção do controlador, todos os parâmetros incluídos nessas equações (chamados "parâmetros nominais") não são conhecidos com precisão absoluta; o sistema de controlo tem que se comportar correctamente, mesmo quando ligado ao sistema físico com os valores verdadeiros dos parâmetros de distância do valor nominal.

. Mesmo admitindo que um modelo "completa" é utilizado na concepção do controlador, todos os parâmetros incluídos nessas equações (chamados "parâmetros nominais") não são conhecidos com precisão absoluta; o sistema de controlo tem que se comportar correctamente, mesmo quando ligado ao sistema físico com os valores verdadeiros dos parâmetros de distância do valor nominal.

Algumas técnicas avançadas de controle incluem um processo de identificação "on-line" (ver mais adiante). Os parâmetros do modelo são calculados ("identificadas"), enquanto o próprio controlador está em execução: desta forma, se uma variação drástica dos parâmetros segue (por exemplo, se o braço do robô libera um peso), o controlador irá ajustar-se, consequentemente, a fim de assegurar o desempenho correto.

Análise

Análise da robustez de um sistema de controlo SISO pode ser feita no domínio da frequência, tendo em conta a função de transferência do sistema e utilização Nyquist e Diagramas de Bode. Os tópicos incluem ganho e margem de fase e margem de amplitude. Para MIMO e, em, sistemas de controle mais complicados gerais deve-se considerar os resultados teóricos elaborados para cada técnica de controle (veja a próxima seção): ou seja, se são necessárias determinadas qualidades de robustez, o engenheiro deve mudar sua atenção para uma técnica de controle incluí-los em suas propriedades.

Restrições

Uma questão de robustez em particular é a exigência de um sistema de controle para executar corretamente na presença de restrições de entrada e estaduais. No mundo físico a cada sinal é limitado. Pode acontecer que um controlador irá enviar sinais de controle que não podem ser seguidos pelo sistema físico: por exemplo, tentando girar uma válvula em velocidade excessiva. Isto pode produzir um comportamento indesejado do sistema de circuito fechado, ou mesmo quebrar actuadores ou outros subsistemas. Técnicas específicas de controlo estão disponíveis para resolver o problema: modelo de controle preditivo (ver mais adiante), e anti-vento de sistemas. Este último é constituído por um bloco de controlo adicional que assegura que o sinal de controlo nunca excede um determinado limiar.

Principais estratégias de controle

Cada sistema de controlo deve garantir em primeiro lugar a estabilidade do comportamento de circuito fechado. Para sistemas lineares, esta pode ser obtida, colocando directamente os pólos. Sistemas de controle não lineares utilizar teorias específicas (normalmente baseado em Teoria de Aleksandr Lyapunov) para garantir a estabilidade sem levar em conta a dinâmica interna do sistema. A possibilidade de cumprir especificações diferentes varia entre o modelo proposto ea estratégia de controle escolhido. Aqui uma lista resumo das principais técnicas de controle é mostrado:

Controle clássico

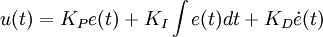

O Controlador PID é provavelmente o projeto de controle de feedback mais utilizado, sendo a mais simples. "PID" significa proporcional-integral-derivativo, referindo-se às três condições de funcionamento do sinal de erro para produzir um sinal de controlo. Se u (t) é o sinal de controlo enviado para o sistema, y (t) é medido e a saída r (t) é a saída desejada e acompanhamento de erro  , Um controlador PID tem a forma geral

, Um controlador PID tem a forma geral

A dinâmica de circuito fechado desejado é obtido ajustando os três parâmetros  ,

,  e

e  , Muitas vezes de forma iterativa por "tuning" e sem conhecimento específico de um modelo de planta. A estabilidade pode muitas vezes ser assegurada utilizando apenas o termo proporcional. O termo integral permite a rejeição de uma perturbação passo (muitas vezes uma especificação impressionante em controle de processo). O termo derivado é utilizado para proporcionar amortecimento ou moldar da resposta. Controladores PID são a classe mais bem estabelecido de sistemas de controlo: no entanto, elas não podem ser usadas em vários casos mais complicados, especialmente se são considerados sistemas MIMO.

, Muitas vezes de forma iterativa por "tuning" e sem conhecimento específico de um modelo de planta. A estabilidade pode muitas vezes ser assegurada utilizando apenas o termo proporcional. O termo integral permite a rejeição de uma perturbação passo (muitas vezes uma especificação impressionante em controle de processo). O termo derivado é utilizado para proporcionar amortecimento ou moldar da resposta. Controladores PID são a classe mais bem estabelecido de sistemas de controlo: no entanto, elas não podem ser usadas em vários casos mais complicados, especialmente se são considerados sistemas MIMO.

Controle Linear

Para sistemas MIMO, posicionamento de pólos pode ser realizada utilizando um matematicamente Representação em espaço de estado do sistema em malha aberta e cálculo de uma matriz de realimentação atribuindo pólos nas posições desejadas. Em sistemas complicados isso pode exigir recursos de cálculo assistidas por computador, e nem sempre pode garantir robustez. Além disso, todos os estados do sistema não estão em observadores medidos e tão geral devem ser incluídas e incorporadas no projeto de alocação de pólos.

Controle não-linear

Processos em indústrias como robótica e da indústria aeroespacial normalmente têm forte dinâmica não-linear. Na teoria de controle, às vezes é possível linearizar essas classes de sistemas e aplicar técnicas lineares: mas, em muitos casos, pode ser necessário conceber teorias de scratch que permitem o controle de sistemas não-lineares. Estes, por exemplo, linearização feedback, backstepping, deslizante de controle de modo, o controle linearização trajetória normalmente tirar proveito dos resultados com base em Lyapunov da teoria. A geometria diferencial tem sido amplamente utilizado como uma ferramenta para a generalização bem conhecidos conceitos de controlo linear para o caso não-linear, bem como mostrar as subtilezas que o tornam um problema mais difícil.

Controle ótimo

Controlo óptimo é uma técnica de controlo particular em que o sinal de controlo de optimizar um determinado "índice de custos": por exemplo, no caso de um satélite, as pressões de jacto necessários para levá-lo a trajectória desejada que consumir a menor quantidade de combustível. Dois métodos de concepção de controlo óptimo têm sido amplamente utilizados em aplicações industriais, como tem sido mostrado que pode garantir a estabilidade de circuito fechado. Estes são Modelo Predictive Control (MPC) e Controle linear-quadrática-Gaussian (LQG). A primeira pode levar mais explicitamente em conta as restrições sobre os sinais do sistema, que é uma característica importante em muitos processos industriais. No entanto, a estrutura de "controlo óptimo" em MPC é apenas um meio para alcançar esse resultado, uma vez que não optimizar um índice de rendimento verdadeiro do sistema de controlo de circuito fechado. Juntamente com controladores PID, sistemas de PCP são a técnica de controle mais utilizado em controle de processo.

Controle adaptativo

Controlo adaptável utiliza identificação em linha dos parâmetros do processo, ou a modificação de ganhos do controlador, obtendo-se, assim, fortes propriedades de robustez. Controles adaptativos foram aplicadas pela primeira vez na indústria aeroespacial no 1950, e de ter encontrado sucesso particular nesse campo.

Controle inteligente

Uso de controle inteligente vários computação AI aborda como redes neurais, Probabilidade Bayesian, lógica fuzzy, aprendizado de máquina, computação evolutiva e algoritmos genéticos para controlar um sistema dinâmico

Controle hierárquico

Um sistema de controlo hierárquico é uma forma de Sistema de Controle em que um conjunto de dispositivos e software de governo é organizado de uma hierárquica árvore. Quando os elos da árvore são implementada por um rede de computadores, que, em seguida, sistema de controlo hierárquico é também uma forma de Sistema de controle de rede.

Literatura

- Christopher Kilian (2005). Moderna tecnologia de controle. Thompson Delmar Learning. ISBN 1-4018-5806-6.

- Vannevar Bush (1929). Análise Operacional Circuit. John Wiley and Sons, Inc ..

- Robert F. Stengel (1994). Optimal Controle e Avaliação. Dover Publications. ISBN 0-486-68200-5, ISBN-13: 978-0-486-68200-6.

- Franklin et ai. (2002). Comentários Controle de Sistemas Dinâmicos (4 ed.). New Jersey: Prentice Hall. ISBN 0-13-032393-4.

- Joseph L. Hellerstein, Amanhecer M. Tilbury, e Sujay Parekh (2004). Comentários Controle de Sistemas de Computação. John Wiley and Sons. ISBN 0-47-126637-X, ISBN-13: 978-0-471-26637-2.

- Diederich Hinrichsen e Anthony J. Pritchard (2005) Sistemas Matemáticos Teoria I -. Modelagem, Análise Espacial, estabilidade e robustez. Springer. ISBN 0-978-3-540-44125-0.

- Sontag, Eduardo (1998) Teoria de Controle de Matemática:. Sistemas de dimensão finita determinística. Segunda Edição. Springer. ISBN 0-387-984895.

![\ x [n] = 0,5 ^ n u [n]](../../images/190/19042.png)

![\ x [n] = 1,5 ^ n u [n]](../../images/190/19045.png)