La ley de Moore

Acerca de este escuelas selección Wikipedia

SOS Children ha intentado que el contenido de Wikipedia más accesible por esta selección escuelas. Haga clic aquí para obtener más información sobre SOS Children.

La ley de Moore describe una tendencia importante en la historia del hardware de la computadora : que el número de transistores que se pueden colocar bajo costo en un circuito integrado está aumentando de manera exponencial , duplicando aproximadamente cada dos años. La observación fue hecha por primera vez por Intel cofundador Gordon E. Moore en un documento de 1965. La tendencia ha continuado durante más de medio siglo y no se espera que parar por otra década por lo menos y tal vez mucho más tiempo.

Casi todas las medidas de las capacidades de los dispositivos electrónicos digitales está vinculado a la ley de Moore: la velocidad de procesamiento, capacidad de memoria, incluso la resolución de las cámaras digitales. Todos ellos están mejorando en (más o menos) exponenciales tasas también. Esto ha aumentado dramáticamente la utilidad de la electrónica digital en casi todos los segmentos de la economía mundial. La ley de Moore describe esta fuerza impulsora del cambio tecnológico y social de finales del siglo 20 y principios de los 21.

Historia

Declaración original de Moore de que el número de transistores se habían duplicado cada año se puede encontrar en su publicación "Abarrotar más componentes en circuitos integrados ", Electrónica Revista 19 de abril 1965:

| " | La complejidad de los costos mínimos de componentes ha aumentado a un ritmo de aproximadamente un factor de dos por año ... Ciertamente en el corto plazo se puede esperar que esta tasa para continuar, si no aumentar. En el largo plazo, la tasa de aumento es un poco más incierto, aunque no hay ninguna razón para creer que no se mantendrá casi constante durante al menos 10 años. Eso significa que para 1975, el número de componentes por circuito integrado de costo mínimo será de 65.000. Creo que un gran circuito de este tipo puede ser construido en una sola oblea. | " |

El término "ley de Moore" fue acuñado en 1970 por el Profesor de Caltech, VLSI pionero, y empresario Carver Mead. Moore puede haber oído Douglas Engelbart, un co- inventor de la mecánica de hoy ratón del ordenador, discutir la reducción de escala proyectada de tamaño del circuito integrado en una conferencia 1960.

En 1975, Moore alteró su proyección a una duplicación cada dos años. A pesar de la creencia popular, él está convencido de que él no predijo una duplicación "cada 18 meses." Sin embargo, un colega Intel había factor en el aumento del rendimiento de los transistores a la conclusión de que los circuitos integrados se duplicaría en el rendimiento de cada 18 meses.

En abril de 2005, Intel ofreció $ 10,000 para comprar una copia del original Revista Electrónica. David Clark, un ingeniero que vive en el Reino Unido, fue el primero en encontrar una copia y ofrecerlo a Intel.

Otras formulaciones y leyes similares

Alan Turing escribió que por el cambio de siglo tendremos computadoras en nuestro escritorio con mil millones de palabras de memoria en la primera parte de su artículo único publicado - esto era de unos 15 años antes de la observación de Moore.

Varias medidas de la tecnología digital están mejorando a un ritmo exponencial en relación con la ley de Moore, incluyendo el tamaño, costo, densidad y velocidad de los componentes. Tenga en cuenta que el propio Moore escribió sólo acerca de la densidad de los componentes (o transistores) a un costo mínimo. Señaló:

La ley de Moore ha sido el nombre que se da a todo lo que cambia de forma exponencial. Digo, si Gore inventó el Internet, inventé la exponencial.

Transistores por circuito integrado. La formulación más popular es de la duplicación del número de transistores en circuitos integrados cada dos años. A finales de la década de 1970, la ley de Moore se hizo conocido como el límite para el número de transistores en los chips más complejos. Las tendencias recientes muestran que esta tasa se ha mantenido en 2007.

Densidad al mínimo coste por transistor. Esta es la formulación dada en el documento de Moore 1965. No se trata sólo de la densidad de transistores que se pueden lograr, pero sobre la densidad de transistores en el que el costo por transistor es el más bajo. A medida que más transistores se ponen en un chip, el costo para hacer cada transistor disminuye, pero la posibilidad de que el chip no funciona debido a un defecto aumenta. En 1965, Moore examinó la densidad de los transistores en el que se minimiza el costo, y se observó que, como transistores se hacen más pequeños a través de los avances en fotolitografía, este número aumentaría a "un ritmo de aproximadamente un factor de dos por año".

El costo por transistor. A medida que el tamaño de los transistores se ha reducido, el costo por transistor ha disminuido también. Sin embargo, el coste de fabricación por unidad de superficie sólo ha aumentado con el tiempo, ya que los materiales y los gastos de energía por unidad de superficie sólo han aumentado con cada nodo de la tecnología sucesiva.

Cálculo de rendimiento por unidad de costo. Además, como el tamaño de los transistores se contrae, la velocidad a la que trabajan aumenta. También es común citar la ley de Moore para referirse al avance rápido de continuar en el cálculo de rendimiento por coste unitario, porque aumento en el recuento de transistor es también una medida aproximada del rendimiento del procesamiento de la computadora. Sobre esta base, el rendimiento de los ordenadores por unidad de costo o más coloquialmente, "explosión por dinero" -doubles cada 24 meses.

El consumo de energía. El consumo de energía de los nodos de cómputo se duplica cada 18 meses.

Costo de almacenamiento en disco duro por unidad de información. Una ley similar (a veces llamada Ley de Kryder) ha mantenido para la costo de almacenamiento de disco duro por unidad de información. La tasa de progresión en almacenamiento en disco en las últimas décadas se ha acelerado en realidad más de una vez, que corresponde a la utilización de códigos de corrección de error, la efecto magnetorresistivo y la efecto magnetorresistivo gigante. La tasa actual de aumento de la capacidad del disco duro es más o menos similar a la tasa de aumento de la cantidad de transistores. Las tendencias recientes muestran que esta tasa se ha mantenido en 2007.

Capacidad de almacenamiento de memoria RAM. Otra versión indica que RAM de capacidad de almacenamiento aumenta al mismo ritmo que la potencia de procesamiento.

Capacidad de la red Según Gerry / Gerald Mantequillas, el ex jefe del Grupo de Redes Ópticas de Lucent en Laboratorios Bell, hay otra versión, llamada Ley de Mantequilla de Photonics, una formulación que es paralelo deliberadamente la ley de Moore. La ley de mantequilla dice que la cantidad de datos que salen de una fibra óptica se duplica cada nueve meses. Por lo tanto, el costo de transmitir un poco más de una red óptica disminuye por medio cada nueve meses. La disponibilidad de multiplexación por división de longitud de onda (a veces llamado "WDM") aumentó la capacidad que podría ser colocado en una sola fibra por tanto como un factor de 100. redes ópticas y DWDM está trayendo rápidamente por el costo de la creación de redes, y un mayor progreso parece asegurado. Como resultado, el precio al por mayor del tráfico de datos se derrumbó en el burbuja de las punto-com. Ley de Nielsen dice que el ancho de banda disponible para usuarios aumenta en un 50% anual.

Píxeles por dólar. Del mismo modo, Barry Hendy de Kodak Australia ha trazado los "píxeles por dólar" como medida básica de valor para una cámara digital, lo que demuestra la linealidad histórica (en una escala logarítmica) de este mercado y la posibilidad de predecir el futuro tendencia del precio de la cámara digital y resolución.

Una profecía autocumplida: la industria se esfuerza por mantenerse al día con la ley de Moore

Aunque la ley de Moore se hizo inicialmente en forma de una observación y pronóstico, el más ampliamente se aceptó, más se desempeñó como meta para toda una industria. Esto condujo a la vez de marketing y de ingeniería departamentos de semiconductores fabricantes a centrarse enorme energía con el objetivo para el incremento especificado en el poder de procesamiento que se presumía una o más de sus competidores no tardaría en realidad alcanzar. En este sentido, puede ser visto como una profecía autocumplida. Por ejemplo, el Hoja de ruta SEMATECH sigue un ciclo de 24 meses.

Las implicaciones de la ley de Moore para ordenador proveedores de componentes son muy significativos. Un proyecto de diseño principales elementos típicos (como un todo-nueva unidad CPU o duro) toma entre dos y cinco años para alcanzar el estado de listo para la producción. En consecuencia, los fabricantes de componentes se enfrentan a enormes presiones-sólo de escala de tiempo de algunas semanas de retraso en un gran proyecto puede significar la diferencia entre éxito y pérdidas masivas, incluso quiebra. Expresado (incorrectamente) como "un duplicando cada 18 meses", la ley de Moore sugiere un progreso fenomenal para la tecnología en el lapso de unos pocos años. Expresado en un corto escala de tiempo, sin embargo, esto equivale a una mejora promedio de rendimiento en la industria en su conjunto de cerca de 1% por semana. Por lo tanto, para un fabricante en el mercado de CPU competitivo, un nuevo producto que se espera que lleve tres años para desarrollar y resulta que sólo tres o cuatro meses de retraso es de 10 a 15% más lento, más voluminoso, o más baja en la capacidad de los productos de la competencia directa , y está cerca de invendible. Si en vez aceptamos que el rendimiento se duplicará cada 24 meses, en lugar de cada 18, un retraso de tres o cuatro meses se traduciría en un rendimiento 11.8% menor.

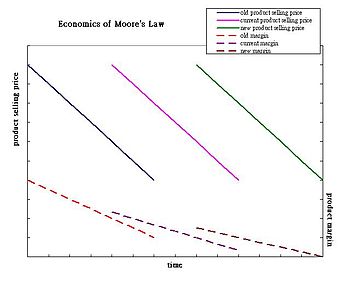

Como el costo de alimentación del sistema para el consumidor cae, el costo para los productores para cumplir la ley de Moore sigue una tendencia opuesta: I + D, fabricación y costes de las pruebas han aumentado constantemente con cada nueva generación de chips. El coste de fabricación por unidad de área está aumentando, pero el área ocupada por el producto final generalmente no disminuye. Fabricantes de circuitos integrados se han basado generalmente en la reducción de los transistores para mejorar el rendimiento mediante la cumplimentación de la misma área de chip con más transistores. Esto ha sido el mejor ejemplo recientemente por la duplicación simultánea de la cantidad de núcleos en una CPU mientras que el tamaño de troquel ha reducido a la mitad aproximadamente.

Como se espera que el costo de los equipos de semiconductores que continúe aumentando, los fabricantes deben vender cantidades cada vez mayores de los chips para seguir siendo rentables. (El costo para cinta de salida de un chip a 180 nm fue de aproximadamente US $ 300.000. El costo de la cinta de salida de un chip a 90 nm supera los US $ 750.000, y se espera que supere los US $ 1.000.000 para 65 nm) A pesar de los crecientes costos, el precio de venta del producto final no se puede esperar que aumente.; en general, tienden a permanecer dentro de la misma gama de precios. Como resultado, se espera que los márgenes de los productos a seguir una tendencia decreciente. En los últimos años, los analistas han observado una disminución en el número de "arranques de diseño" en los nodos de procesos avanzados (130 nm y por debajo de 2007). Aunque estas observaciones se realizaron en el período posterior a la crisis económica de 2000, el descenso puede ser evidencia de que los fabricantes tradicionales en el largo plazo mercado global no puede sostener económicamente la ley de Moore.

Tendencias de futuro

Tecnología "hojas de ruta de la industria del ordenador predicen (en 2001) que la ley de Moore continuará por varias generaciones de chips. Dependiendo del tiempo de duplicación utilizado en los cálculos, esto podría significar un aumento de hasta cien veces más en número de transistores por chip dentro de una década. La hoja de ruta de la tecnología de la industria de semiconductores utiliza un tiempo de duplicación de tres años para microprocesadores, lo que lleva a un aumento de diez veces en la próxima década. Intel se informó en 2005 como indicando que la reducción del tamaño de silicio chips con buena economía puede continuar durante la próxima década y en 2008 como la predicción de la tendencia a través de 2029. De hecho, la Ley de Moore se ha acelerado en el caso de NAND Memoria Flash, que se utiliza para el almacenamiento en cámaras digitales, unidades flash, Reproductores de MP3, y más recientemente, las unidades de estado sólido (SSD).

Algunas de las nuevas direcciones en la investigación que permitan la ley de Moore para continuar son:

- La predicción de Intel de aumentar el uso de materiales distintos al silicio se verificó a mediados de 2006, así como su intención de utilizar transistores trigate de todo 2009.

- Los investigadores de IBM y Georgia Tech ha creado un nuevo récord de velocidad cuando se quedaron un silicio / germanio helio superenfriada transistor a 500 gigahercios (GHz). El transistor funciona por encima de 500 GHz a 4,5 K (-451 ° F / -268,65 ° C) y simulaciones mostraron que es probable que podría funcionar a 1 THz (1,000 GHz). Este ensayo sólo se probó un solo transistor, sin embargo. CPUs de escritorio prácticos que se ejecutan a esta velocidad son extremadamente poco probable el uso de técnicas de chips de silicio contemporáneo.

- A principios de 2006, IBM investigadores anunciaron que habían desarrollado una técnica para imprimir circuitos sólo 29,9 nm de ancho usando profundas ultravioleta (DUV, 193 nanómetros) litografía óptica. IBM afirma que esta técnica podría permitir a los fabricantes de chips que utilizan métodos actuales durante siete años sin dejar de lograr los resultados previstos por la ley de Moore. Se espera que los nuevos métodos que pueden alcanzar los circuitos más pequeños para ser sustancialmente más caro.

- En 27 de enero de 2007 , Intel demostró un trabajo Chip de 45nm con nombre en código " Penryn ", con la intención producción en masa para comenzar a finales de 2007. Una década antes de esa fecha, los chips se construyeron utilizando un proceso de 350 nm.

- Las empresas están trabajando en el uso de nanotecnología para resolver los complejos problemas de ingeniería que participan en la producción de patatas fritas en el 32 nm y los niveles más pequeños. (El diámetro de un átomo de silicio es del orden de 0,2 nm.)

- En abril de 2008, los investigadores de HP Labs anunciaron la creación de un grupo de trabajo " memristor ":.. un cuarto elemento de circuito pasivo básica cuya existencia sólo se había teorizado propiedades únicas del memristor permiten la creación de pequeñas y mejor rendimiento de dispositivos electrónicos Esta memristor tiene cierta semejanza con memoria resistiva ( CBRAM o RRAM) desarrollada de forma independiente y recientemente por otros grupos para aplicaciones de memoria no volátil.

Si bien este horizonte para el escalado la ley de Moore es posible, que no viene sin subyacente retos de ingeniería. Uno de los principales retos en los circuitos integrados que utilizan transistores a nanoescala es aumento de variación de los parámetros y corrientes de fuga. Como resultado de la variación y de fuga, la márgenes de diseño disponibles para hacer el diseño predictivo son cada vez más difícil. Estos sistemas también se disipan poder considerable incluso cuando no están cambiando. Adaptable y estadística diseño junto con la reducción de las fugas de energía es fundamental para mantener la escala de CMOS. Un buen tratamiento de estos temas se cubre en Fugas en nanómetros CMOS Technologies. Otros retos de escala incluyen:

- La capacidad de controlar la resistencia y la capacitancia parásita en los transistores,

- La capacidad para reducir la resistencia y la capacitancia eléctrica en interconexiones,

- La capacidad de mantener transistor adecuado electrostática para permitir que el terminal de puerta para controlar el comportamiento ON / OFF,

- Efecto de la línea de borde rugosidad Creciente,

- Dopante fluctuaciones,

- Entrega de potencia a nivel de sistema,

- Diseño térmico para manejar con eficacia la disipación de la energía entregada, y

- Solución de todos estos desafíos a un costo de fabricación cada vez reductor del sistema en general.

Últimos límites de la ley

En 1995, el "poderoso" Chip de DEC Alpha (adquirida por Compaq, ahora parte de Hewlett-Packard) se compone de aproximadamente nueve millones de transistores. Este procesador de 64 bits era una punta de lanza tecnológica en el momento, aunque la cuota de mercado del circuito permaneció media. Seis años más tarde, un estado del microprocesador arte tendría más de 40 millones de transistores. En 2015, se cree que estos procesadores deben contener más de 15 mil millones de transistores. Las cosas están cada vez más pequeños cada año. Si esto sigue así, en teoría, en menos de 10 años se crearán equipos donde cada molécula tendrá su propio lugar, es decir, habremos entrado por completo la era de la producción a escala molecular.

En 13 de abril de 2005 , él mismo declaró en una entrevista que la ley no puede sostenerse indefinidamente Gordon Moore: ". No puede seguir para siempre el carácter de exponenciales es que cuando les mueves y eventualmente desastre sucede" y señaló que transistores eventualmente llegar a los límites de la miniaturización en niveles atómicos:

| " | En términos de tamaño [de transistor] se puede ver que nos estamos acercando al tamaño de átomos que es una barrera fundamental, pero será dos o tres generaciones antes de que lleguemos tan lejos, pero eso es tan lejos como hemos Alguna vez ha sido capaz de ver. Tenemos otros 10 a 20 años antes de llegar a un límite fundamental. Para entonces van a ser capaces de hacer los chips más grandes y tienen presupuestos de transistores en los miles de millones. | " |

Lawrence Krauss y Glenn D. Starkman anunció un límite máximo de alrededor de 600 años, en su papel "Límites Universales de Computación", con base en la estimación rigurosa de la capacidad total de procesamiento de información de cualquier sistema en el Universo .

Por otra parte, la ley a menudo se ha reunido obstáculos que parecían insuperables, antes pronto superarlos. En ese sentido, Moore dice que ahora ve a su ley como más hermosa de lo que se había dado cuenta: "La ley de Moore es una violación de Ley de murphy. Todo se pone mejor y mejor ".

Es posible que con el tiempo la computación cuántica puede permitir la computación para superar las restricciones de tamaño nivel atómico, sin embargo, esto no parece a su alcance en el futuro previsible.

Futuristas y la ley de Moore

La extrapolación basada en parte en la ley de Moore ha llevado futuristas como Vernor Vinge, Bruce Sterling, y Ray Kurzweil a especular sobre un singularidad tecnológica. Kurzweil proyecta que la continuación de la ley de Moore hasta el 2019 dará lugar a características de transistores a pocos átomos de ancho. Aunque esto significa que la estrategia de cada vez más fina fotolitografía se habrá llegado a su fin, se especula que esto no significa el fin de la ley de Moore:

| " | La ley de Moore de los Circuitos Integrados no fue el primero, pero el quinto paradigma para pronosticar acelerar relación precio-rendimiento. Dispositivos de computación se han multiplicado consistente en potencia (por unidad de tiempo) de los dispositivos de cálculo mecánicos utilizados en el 1890 Censo de Estados Unidos, a [ ] Relé de base de Newman " [Heath] Robinson "máquina que rompió el nazi [ Lorenz cipher], a la CBS equipo de tubo de vacío que predijo la elección de Eisenhower , a las máquinas basados en transistores utilizados en la primera lanzamientos espaciales, al ordenador personal basado en circuitos integrados. | " |

Por lo tanto, Kurzweil conjetura que es probable que algunos de los nuevos tipo de tecnología reemplazará la tecnología de circuitos integrados actual, y que la Ley de Moore será verdad mucho después de 2020. Él cree que el crecimiento exponencial de la ley de Moore continuará más allá del uso de los circuitos integrados en tecnologías que conduzcan a la singularidad tecnológica. La Ley de Aceleración de Devoluciones descritos por Ray Kurzweil ha de muchas maneras alterado la percepción del público de la Ley de Moore. Es una creencia común (pero errónea) de que la Ley de Moore hace predicciones sobre todas las formas de tecnología, cuando en realidad sólo se refiere a los semiconductores circuitos. Muchos futuristas siguen utilizando el término "ley de Moore" en este sentido más amplio para describir ideas como los esgrimidos por Kurzweil.

Software: violar la ley

Un punto a veces mal entendido es que mejoró exponencialmente hardware no implica necesariamente mejoró exponencialmente el rendimiento del software para ir con ella. La productividad de los desarrolladores de software con toda seguridad no aumenta exponencialmente con la mejora en el hardware, pero la mayoría de las medidas ha aumentado sólo lentamente y de manera irregular durante décadas. El software tiende a hacerse más grandes y más complicado con el tiempo, y La ley de Wirth incluso afirma con humor que "Software se vuelve más lento más rápido que el hardware se hace más rápido".

Hay problemas en los incrementos exponenciales en potencia de procesamiento se igualado o superado por el aumento exponencial en complejidad a medida que aumenta el tamaño del problema. (Ver teoría de la complejidad computacional y clases de complejidad P y NP para una discusión un tanto teórica de tales problemas, que se producen muy comúnmente en aplicaciones tales como la programación.)

Debido a la potencia matemática de crecimiento exponencial (similar al poder financiero de interés compuesto), las fluctuaciones aparentemente menores en las tasas de crecimiento relativo de rendimiento de la CPU, capacidad de memoria RAM y espacio en disco por dólar han provocado que los costes relativos de estos tres recursos fundamentales de computación a cambiar notablemente en los últimos años, que a su vez ha provocado importantes cambios en los estilos de programación. Para muchos problemas de programación, el desarrollador tiene que decidir en numerosas concesiones del espacio-tiempo, ya lo largo de la historia de computar estas elecciones han sido fuertemente influenciada por los costos relativos cambiantes de ciclos de CPU frente a espacio de almacenamiento.

Además de procesador de uso / almacenamiento de espacio de compensaciones, a menudo hay una correlación entre el tiempo de desarrollo, complejidad de la aplicación, y rendimiento de la aplicación. Un ejemplo de esto sería el algoritmo de ordenación tipo de inserción en comparación con el algoritmo quicksort. Mientras que un ordenamiento por inserción es uno de los algoritmos de ordenación más fácil y menos compleja para aplicar, sino que también es un poco lento para grandes cantidades de datos. Como el rendimiento del procesador aumenta, los programadores pueden decidir aplicar algoritmos más lentas y menos complejos a favor de un menor tiempo de desarrollo.

Otras consideraciones

No todos los aspectos de la tecnología informática se desarrolla en la capacidad y velocidad de acuerdo con la ley de Moore. Memoria de acceso aleatorio (RAM) y velocidades disco duro de los tiempos de búsqueda de mejorar en el mejor de unos pocos puntos porcentuales cada año. Puesto que la capacidad de memoria RAM y unidades de disco duro está aumentando mucho más rápido que es su velocidad de acceso, el uso inteligente de su capacidad se vuelve más y más importante. Ahora tiene sentido en muchos casos a espacio comercial para el tiempo, como por precomputen índices y almacenarlos de manera que facilite el acceso rápido, a costa de utilizar más espacio en disco y memoria: el espacio es cada vez más barato en relación con el tiempo.

Por otra parte, hay una creencia popular que la velocidad de reloj de un procesador determina su velocidad, también conocido como el Megahertz Mito. En realidad, esto depende también del número de instrucciones por garrapata que pueden ejecutarse (así como la complejidad de cada instrucción, ver MIPS, RISC y CISC), y así la velocidad de reloj sólo se puede utilizar para la comparación entre dos circuitos idénticos. Por supuesto, otros factores deben ser tomados en consideración como la ancho de bus y la velocidad del periféricos. Por lo tanto, las evaluaciones más populares de la "velocidad de la computadora" son intrínsecamente parcial, sin una comprensión de la tecnología subyacente. Esto fue especialmente cierto durante el Era Pentium cuando los fabricantes populares juegan con la percepción pública de la velocidad, que se centran en la publicidad de la velocidad de reloj de nuevos productos.

Otra idea falsa popular que circula la ley de Moore es la suposición incorrecta de que el crecimiento del transistor procesador exponencial, según lo predicho por Moore, se traduce directamente en la capacidad de procesamiento aumento o procesamiento velocidad exponencial proporcional. Si bien el aumento de los transistores en los procesadores por lo general tienen un efecto sobre el aumento de la potencia de procesamiento o la velocidad, la relación entre los dos factores no es proporcional. Hay casos en que un aumento de ~ 45% en los transistores del procesador se han traducido a más o menos 10 a 20% de aumento en la potencia de procesamiento o la velocidad. Diferentes familias de procesadores tienen diferentes aumentos de rendimiento cuando se incrementa número de transistores. Más precisamente, el rendimiento del procesador o el poder es más relacionado con otros factores como la microarquitectura y velocidad de reloj dentro de la misma familia de procesadores. Es decir, el rendimiento del procesador puede aumentar sin aumentar el número de transistores en un procesador. ( Los procesadores AMD64 tuvieron un mejor rendimiento general en comparación con el difunto Pentium 4 serie, que tenía más transistores).

También es importante señalar que densidad de transistores en multi-core CPUs no refleja necesariamente un aumento similar en potencia de cálculo práctico, debido a la unparallelised naturaleza de la mayoría de las aplicaciones.