Entropy

Fundo para as escolas Wikipédia

Crianças SOS oferecem um download completo desta seleção para as escolas para uso em escolas intranets. Todas as crianças disponíveis para apadrinhamento de crianças de Crianças SOS são cuidadas em uma casa de família pela caridade. Leia mais ...

| Artigos de entropia |

|---|

| Introdução |

| História |

| Clássico |

| Estatístico |

Em termodinâmica (um ramo da física ), a entropia é uma medida da indisponibilidade de um do sistema de energia para fazer o trabalho .

É uma medida da aleatoriedade das moléculas de um sistema e é central para a segunda lei da termodinâmica e do direito combinado da termodinâmica, que lidam com processos físicos e se eles ocorrem espontaneamente. Mudanças espontâneas, em sistemas isolados, ocorrer com o aumento da entropia. Mudanças espontâneas tendem a atenuar as diferenças na temperatura , pressão, densidade , e potencial químico que podem existir em um sistema, e a entropia é assim uma medida de quão longe deste processo de suavização-out progrediu.

A palavra "entropia" é derivada do grego εντροπία "voltando-se para um" (εν- "em" + τροπή "uma viragem"), e é simbolizada por S na física.

Explicação

Quando a energia de um sistema é definido como a soma da sua energia "útil", (por exemplo, que usado para empurrar um êmbolo), e a sua "energia inúteis", isto é, que a energia que não pode ser utilizado para trabalho externo , seguida de entropia pode ter (mais concretamente) visualizada como o "refugo" ou energia "inúteis", cuja prevalência enérgico sobre o total de energia de um sistema é directamente proporcional à temperatura absoluta do considerado sistema. (Observe os produtos "TS" no Gibbs energia livre ou Helmholtz relações de energia livre).

A entropia é uma função de uma quantidade de calor que mostra a possibilidade de conversão desse calor em trabalho. O aumento da entropia é pequena quando o calor é adicionado a uma temperatura elevada e é maior quando é adicionado calor à temperatura mais baixa. Assim, para o máximo de entropia há disponibilidade mínima para a conversão em trabalho e para a entropia mínimo existe a máxima disponibilidade para a conversão em trabalho.

Quantitativamente, a entropia é definida pela quantidade diferencial  , Onde

, Onde  é a quantidade de calor absorvida em uma isotérmica e processo reversível, em que o sistema vai de um estado para outro, e T é a temperatura absoluta em que o processo está a ocorrer. A entropia é um dos factores que determina a energia livre do sistema. Esta definição termodinâmico de entropia é válida apenas para um sistema em equilíbrio (porque a temperatura está definido apenas por um sistema em equilíbrio), enquanto que a definição estatística da entropia (ver abaixo) aplica-se a qualquer sistema. Assim, a definição estatística é geralmente considerada a definição fundamental da entropia.

é a quantidade de calor absorvida em uma isotérmica e processo reversível, em que o sistema vai de um estado para outro, e T é a temperatura absoluta em que o processo está a ocorrer. A entropia é um dos factores que determina a energia livre do sistema. Esta definição termodinâmico de entropia é válida apenas para um sistema em equilíbrio (porque a temperatura está definido apenas por um sistema em equilíbrio), enquanto que a definição estatística da entropia (ver abaixo) aplica-se a qualquer sistema. Assim, a definição estatística é geralmente considerada a definição fundamental da entropia.

Variação de entropia tem sido geralmente definido como uma alteração em um mais estado desordenado a um nível molecular. Nos últimos anos, a entropia foi interpretada em termos de o " dispersão "de energia. A entropia é uma extenso função de estado que é responsável pelos efeitos de irreversibilidade sistemas termodinâmicos.

Em termos de mecânica estatística , a entropia descreve o número do possível microscópicas configurações do sistema. A definição estatística de entropia é a definição mais fundamental, a partir da qual todas as outras definições e todas as propriedades da entropia seguir.

Origem do conceito

A primeira lei da termodinâmica , formalizado por meio dos experimentos de calor de atrito James Joule em 1843, lida com o conceito de energia, o que é conservada em todos os processos; a primeira lei, no entanto, carece de na sua capacidade para quantificar os efeitos de e atrito dissipação.

O conceito de entropia foi desenvolvido na década de 1850 pelo alemão físico Rudolf Clausius que a descreveu como o teor de transformação, ou seja, de dissipação de energia uso, de um ou sistema termodinâmico corpo de trabalho espécies químicas durante uma mudança de estado.

Embora o conceito de entropia era originalmente uma construção termodinâmica, foi adaptado em outros campos de estudo, incluindo teoria da informação, psicodinâmica, thermoeconomics e evolução .

História

A história da entropia começa com o trabalho do francês matemático Lazare Carnot que em seus 1.803 papel Princípios Fundamentais de Equilíbrio e Movimento propôs que em qualquer máquina as acelerações e choques das peças móveis representam todas as perdas de momento da atividade. Em outras palavras, em qualquer processo natural, existe uma tendência inerente para a dissipação de energia útil. Com base neste trabalho, em 1824, filho de Lazare Sadi Carnot publicou Reflexões sobre a Motive Power of Fire em que expôs o ponto de vista que em todos os motores de calor sempre " calórica ", ou o que hoje é conhecido como calor , cai por uma diferença de temperatura, que o trabalho ou força motriz pode ser produzido a partir das ações da "queda do calórica" entre um corpo quente e fria. Esta foi uma primeira perspectiva da segunda lei da termodinâmica .

Carnot baseou seus pontos de vista de calor parcialmente no início do século 18 "hipótese newtoniana" que tanto calor e luz eram tipos de formulários indestrutíveis da matéria, que são atraídos e repelidos por outro assunto, e parcialmente sobre as visões contemporâneas de Contagem Rumford que mostrou em 1789 que o calor poderia ser criado por fricção como quando furos de canhão são usinadas. Por conseguinte, Carnot fundamentado que, se o corpo da substância de trabalho, tal como um corpo de vapor é trazido de volta ao seu estado original (temperatura e pressão) com o fim de uma completa ciclo do motor, que "nenhuma alteração ocorre na condição de o corpo de trabalho." Este último comentário foi alterado em suas notas de rodapé, e foi este comentário que levou ao desenvolvimento da entropia.

Na década de 1850 e 60, o físico alemão Rudolf Clausius gravemente objecções a esta última hipótese, ou seja, que nenhuma mudança ocorre no corpo de trabalho, e deu esta "mudança" uma interpretação matemática, questionando a natureza da perda inerente de calor utilizável quando o trabalho é feito, por exemplo, o calor produzido pelo atrito. Isso foi em contraste com visões anteriores, com base nas teorias de Isaac Newton , que o calor era uma partícula indestrutível que tinha em massa. Mais tarde, cientistas como Ludwig Boltzmann, Josiah Willard Gibbs , e James Clerk Maxwell deu entropia uma base estatística. Carathéodory ligada entropia com a definição matemática de irreversibilidade, em termos de trajetórias e integrabilidade.

Definições e descrições

Na ciência, o termo "entropia" é geralmente interpretado de três maneiras distintas, mas semi-relacionados, ou seja, do ponto de vista macroscópico ( termodinâmica clássica ), um ponto de vista microscópico ( termodinâmica estatística ), e um ponto de vista da informação ( teoria da informação).

A definição estatística da entropia (ver abaixo) é a definição fundamental porque os outros dois podem ser matematicamente derivada dela, mas não vice-versa. Todas as propriedades de entropia (incluindo a segunda lei da termodinâmica ) seguem a partir desta definição.

Ponto de vista macroscópico (termodinâmica clássica)

| Variáveis conjugadas da termodinâmica | |

|---|---|

| Pressão | Volume |

| ( Estresse) | ( Strain) |

| Temperatura | Entropy |

| Potencial químico | Número de partículas |

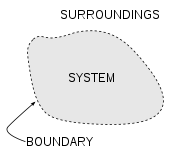

Em um sistema termodinâmico, um "universo" que consiste em "ambiente" e "sistemas" e composta por quantidades de matéria, as suas diferenças de pressão, diferenças de densidade, e as diferenças de temperatura tendem a equalizar todos ao longo do tempo - simplesmente porque estado de equilíbrio tem maior probabilidade (mais possível combinações de microestados) do que qualquer outro - ver mecânica estatística . No exemplo derretimento do gelo , a diferença de temperatura entre uma sala quente (o ambiente) e vidro frio de gelo e água (o sistema e não parte do quarto), começa a ser equalizado como porções da energia térmica do ambiente acolhedor espalhar-se para o sistema de refrigeração de gelo e água.

Ao longo do tempo a temperatura do vidro e o seu conteúdo e a temperatura da sala tornam-se iguais. A entropia do quarto diminuiu como parte de sua energia foi disperso ao gelo e água. No entanto, como calculado no exemplo, a entropia do sistema de gelo e água aumentou mais do que a entropia do ambiente circundante diminuiu. Numa sistema isolado, como o quarto água e gelo em conjunto, a dispersão de energia a partir de mais quente para o resfriador sempre resulta em um aumento líquido na entropia. Assim, quando a 'universo' do sistema de água e gelo quarto tiver atingido um equilíbrio da temperatura, a variação de entropia do estado inicial está no máximo. A entropia do sistema termodinâmico é uma medida de como a equalização progrediu.

Um caso especial de o aumento da entropia, o entropia da mistura, ocorre quando duas ou mais substâncias diferentes são misturadas. Se as substâncias estão à mesma temperatura e pressão, não haverá permuta de calor ou líquido de trabalho - o aumento da entropia será inteiramente devido à mistura de diferentes substâncias.

Do ponto de vista macroscópico, em termodinâmica clássica a entropia é interpretado simplesmente como um função de estado de um sistema termodinâmico: isto é, uma propriedade dependendo apenas do estado actual do sistema, independentemente de como o estado que veio a ser alcançado. A função de estado tem a propriedade importante que, quando multiplicado por uma temperatura de referência, que pode ser entendida como uma medida da quantidade de energia num sistema físico que não pode ser usado para fazer o trabalho termodinâmico ; ou seja, o trabalho mediada por energia térmica. Mais precisamente, em qualquer processo em que o sistema fornece energia Δ E, e sua entropia cai por Δ S, uma quantidade de, pelo menos, T R Δ S de que a energia deve ser dada até os arredores do sistema como inutilizável calor (T R é o temperatura do ambiente externo do sistema). Caso contrário, o processo não irá para a frente.

Em 1862, Clausius afirmou que ele chama de "teorema respeitando os valores de equivalência das transformações" ou o que agora é conhecido como a segunda lei da termodinâmica , como tal:

- A soma algébrica de todas as transformações que ocorrem num processo cíclico só pode ser positivo, ou, como um caso extremo, igual a nada.

Quantitativamente, Clausius indica a expressão matemática para este teorema é como se segue. Deixe δQ ser um elemento do calor cedido pelo corpo a qualquer reservatório de calor durante as suas próprias alterações, calor que pode absorver a partir de um reservatório a ser aqui considerados como negativos, e T a temperatura absoluta do corpo no momento de dar -se este calor, então a equação:

deve ser verdade para cada processo cíclico reversível, ea relação:

deve possuir bom para cada processo cíclico que é de qualquer maneira possível. Isto é essencial a formulação da segunda lei e uma das formas originais do conceito de entropia. Pode ser visto que as dimensões de entropia energia são divididos por temperatura, que é o mesmo que as dimensões de Constante (k B) de Boltzmann e capacidade de calor. O Unidade SI da entropia é " joule por kelvin "(J · K-1). Deste modo, a quantidade" Ds "é utilizado como um tipo de energia interna, o que explica os efeitos de irreversibilidade, na equação do balanço de energia para um determinado sistema. Em a energia livre de Gibbs equação, ou seja ΔG = AH - TΔS, por exemplo, que é uma fórmula comumente utilizados para determinar se as reacções químicas que ocorrem, a energia relacionado com a variação de entropia TΔS é subtraído do AH "total" de energia do sistema para dar o "livre" ΔG energia do sistema, como durante uma processo químico ou como quando um sistema muda de estado.

Definição microscópica da entropia (mecânica estatística)

Em termodinâmica estatística da entropia é definida como o número de configurações microscópicas que resultam na observado descrição macroscópica do sistema termodinâmico:

onde

- k B é A constante de Boltzmann 1,38066 × 10 -23 J K-1 e

-

é o número de microestados correspondentes ao macroestado termodinâmica observada.

é o número de microestados correspondentes ao macroestado termodinâmica observada.

Esta definição é considerado para ser a definição fundamental de entropia (como todas as outras definições pode ser matematicamente derivada dela, mas não vice-versa). Em 1896 leituras de Boltzmann na teoria do gás, que mostraram que a expressão não fornece uma medida de entropia para sistemas de átomos e moléculas em fase gasosa, proporcionando assim uma medida para a entropia da termodinâmica clássica.

Em 1877, Boltzmann visualizado de forma probabilística para medir a entropia de um conjunto de partículas de gás ideais, em que ele definidas entropia ser proporcional ao logaritmo do número de micro tal gás poderia ocupar. Daqui em diante, o problema essencial na termodinâmica estatística , ou seja, de acordo com a Schrödinger, foi para determinar a distribuição de uma dada quantidade de energia E em relação aos sistemas idênticos N.

Mecânica estatística entropia explica como a quantidade de incerteza (ou "mixedupness" na frase de Gibbs ) que permanece sobre um sistema, depois de suas propriedades macroscópicas observáveis foram tidas em conta. Para um dado conjunto de variáveis macroscópicas, como a temperatura e o volume, a entropia mede o grau para o qual a probabilidade de o sistema está distribuído em diferentes estados quânticos possíveis. Os mais estados disponíveis para o sistema com maior probabilidade, maior a entropia. Mais especificamente, é uma entropia medida logarítmica do densidade de estados. Em essência, a interpretação mais geral é de entropia como uma medida do nosso incerteza sobre um sistema. O estado de equilíbrio de um sistema maximiza a entropia porque perdemos toda a informação sobre as condições iniciais, exceto para as variáveis conservadas; maximizar a entropia maximiza a nossa ignorância sobre os detalhes do sistema. Esta incerteza não é do cotidiano tipo subjetivo, mas sim a incerteza inerente ao método experimental e modelo interpretativo.

Na escala molecular, as duas definições igualar-se, porque a adição de calor a um sistema, o que aumenta a sua entropia termodinâmica clássica, aumenta também do sistema flutuações térmicas , dando assim um aumento da falta de informação sobre o estado microscópico exacta do sistema, ou seja, um aumento entropia mecânica estatística.

O modelo interpretativa tem um papel central na determinação da entropia. O qualificador "para um determinado conjunto de variáveis macroscópicas" acima tem implicações muito profundas: se dois observadores usam diferentes conjuntos de variáveis macroscópicas, então eles vão observar diferentes entropias. Por exemplo, se um observador utiliza as variáveis U, V e W, e observador B usa U, V, W, X, em seguida, alterando X, observador B pode causar um efeito que se parece com uma violação da segunda lei da termodinâmica ao observador A. Em outras palavras: o conjunto de variáveis macroscópicas um escolhe deve incluir tudo o que pode mudar no experimento, caso contrário, pode-se ver a diminuir a entropia!

Entropia em termodinâmica química

A entropia termodinâmica é fundamental na termodinâmica química, permitindo mudanças a serem quantificados e os resultados das reações previsto. A segunda lei da termodinâmica, a entropia da combinação de um sistema e seus arredores (ou numa sistema isolado por si só) aumenta durante todos os processos químicos e físicos espontâneos. Espontaneidade em química significa "por si só, ou sem qualquer influência externa", e não tem nada a ver com a velocidade. A equação de Clausius de δ q rev / T = Δ S introduz a medida da variação de entropia, Δ S. Mudança de entropia descreve a direção e quantifica a magnitude das mudanças simples, como calor transferência entre os sistemas - sempre de mais quente para o resfriador espontaneamente. Assim, quando um mole de substância a 0 K é aquecido pelos seus arredores para 298 K, a soma dos valores incrementais de q rev / T constituem de entropia molar padrão do composto uma propriedade fundamental física cada elemento ou, e um indicador da quantidade de energia armazenada por um substância a 298 K. A entropia mudança também mede a mistura de substâncias como um somatório de suas quantidades relativas na mistura final.

A entropia é igualmente essencial para prever o grau de reacções químicas complexas, isto é, se um processo vai prosseguir como escrito ou na direcção oposta. Para essas aplicações, Δ S deve ser incorporado em uma expressão que inclui o sistema e seus arredores, Δ S universo = Δ S arredores sistema Δ + S. Esta expressão torna-se, através de alguns passos, a energia livre de Gibbs equação para reagentes e produtos no sistema: Δ G [a energia livre de Gibbs mudança do sistema] = Δ H [a entalpia mudança] - T Δ S [a variação de entropia] .

A segunda lei

Um importante lei da física, a segunda lei da termodinâmica , afirma que a entropia total de qualquer sistema termodinâmico isolado tende a aumentar ao longo do tempo, aproximando-se um valor máximo; e assim, por implicação, a entropia do universo (ou seja, o sistema e seus arredores), assume-se como um sistema isolado, tende a aumentar. Duas consequências importantes são que o calor da própria não pode passar de um para um corpo mais frio quente, ou seja, é impossível transferir calor a partir de um reservatório frio para um quente, sem ao mesmo tempo a conversão de uma certa quantidade de trabalho a aquecer. Também é impossível para qualquer dispositivo que pode operar em um ciclo para receber o calor de um único reservatório e produzir um montante líquido de trabalho; só pode obter um trabalho útil para fora do calor se calor é, ao mesmo tempo quente transferido de um reservatório para um frio. Isto significa que não há possibilidade de um isolado " Sistema Contínuo movimento ". Também, a partir desta segue-se que uma redução no aumento de entropia em um processo especificado, tal como uma reacção química , significa que é energicamente mais eficiente.

Em geral, de acordo com a segunda lei, a entropia de um sistema que não é isolado pode diminuir. Um aparelho de ar condicionado, por exemplo, arrefece o ar numa sala, reduzindo, assim, a entropia do ar. O calor, contudo, envolvidos na operação do aparelho de ar condicionado faz sempre uma maior contribuição para a entropia do ambiente do que o aumento da entropia do ar. Assim, a entropia total do quarto e o meio ambiente aumenta, de acordo com a segunda lei.

Equação do balanço de entropia para sistemas abertos

Em engenharia química, os princípios da termodinâmica são normalmente aplicados ao " sistemas abertos ", isto é, aqueles em que o calor , o trabalho , e massa de fluxo entre o limite do sistema. Num sistema em que há fluxos de calor (tanto  ) E trabalho, ou seja,

) E trabalho, ou seja,  (Trabalho de eixo) e P (dV / dt) (trabalho de pressão-volume), entre os limites do sistema, o fluxo de calor, mas não o fluxo de trabalho, faz com que uma mudança na entropia do sistema. Esta taxa de variação de entropia é

(Trabalho de eixo) e P (dV / dt) (trabalho de pressão-volume), entre os limites do sistema, o fluxo de calor, mas não o fluxo de trabalho, faz com que uma mudança na entropia do sistema. Esta taxa de variação de entropia é  em que T é o absoluto temperatura termodinâmica do sistema no ponto do fluxo de calor. Se, além disso, existem fluxos maciços através dos limites do sistema, a entropia total do sistema também vai mudar devido a este fluxo de convecção.

em que T é o absoluto temperatura termodinâmica do sistema no ponto do fluxo de calor. Se, além disso, existem fluxos maciços através dos limites do sistema, a entropia total do sistema também vai mudar devido a este fluxo de convecção.

Para derivar uma equação equilibrada entropia generalizada, começamos com a equação de equilíbrio geral para a mudança em qualquer Θ extensa quantidade em um sistema termodinâmico, uma quantidade que pode ser ou conservada, tais como a energia, ou não conservada, tais como entropia. A expressão genérica de base equilíbrio afirma que dΘ / dt, ou seja, a taxa de mudança de Θ no sistema, é igual à velocidade à qual entra no sistema Θ nos limites, menos a taxa na qual Θ sai do sistema através dos limites do sistema, além a taxa a que Θ é gerado dentro do sistema. Usando esta equação equilíbrio genérico, no que diz respeito à taxa de variação com o tempo da grande quantidade de entropia S, a equação de equilíbrio de entropia para um sistema termodinâmico aberto é:

onde

= A taxa líquida de fluxo de entropia devido aos fluxos de massa para dentro e fora do sistema (onde

= A taxa líquida de fluxo de entropia devido aos fluxos de massa para dentro e fora do sistema (onde  = Entropia por unidade de massa).

= Entropia por unidade de massa).

= Taxa de fluxo de entropia devido ao fluxo de calor através do limite do sistema.

= Taxa de fluxo de entropia devido ao fluxo de calor através do limite do sistema.

= A taxa de geração de entropia interna dentro do sistema.

= A taxa de geração de entropia interna dentro do sistema.

Note-se, também, que se houver vários fluxos de calor, o termo  está a ser substituído por

está a ser substituído por  onde

onde  é o fluxo de calor e

é o fluxo de calor e  é a temperatura na porta de fluxo de calor j no sistema.

é a temperatura na porta de fluxo de calor j no sistema.

Entropia em mecânica quântica (von Neumann entropia)

Em mecânica estatística quântica, o conceito de entropia foi desenvolvida por John von Neumann, e é geralmente referida como "von Neumann entropia". Von Neumann estabeleceu a estrutura matemática correta para a mecânica quântica com seu trabalho Mathematische Grundlagen der Quantenmechanik. Ele forneceu neste trabalho uma teoria de medição, onde a noção habitual de colapso onda é descrito como um processo irreversível (o chamado von Neumann ou medição projetiva). Utilizando este conceito, em conjunto com o matriz densidade ele estendeu o conceito clássico de entropia para o domínio quântico.

É bem conhecido que uma definição baseada Shannon de informação entropia conduz no caso clássico para a entropia de Boltzmann. É tentador considerar a entropia Von Neumann como a definição da mecânica quântica correspondente. Mas esta última é problemática do ponto de informação quântica de vista. Consequentemente Stotland, Pomeransky, Bachmat e Cohen introduziram uma nova definição de entropia que reflete a incerteza inerente de estados quânticos. Esta definição permite distinguir entre a entropia incerteza mínimo de estados puros, e o excesso de entropia estatística de misturas.

Entropia em Astrofísica

Em astrofísica, o que é referido como "entropia" é realmente a constante adiabática derivado da seguinte forma.

Usando a primeira lei da termodinâmica para, um processo infinitesimal quase estático para um sistema hidrostático

Para um gás ideal neste caso especial, a energia interna, L, é apenas uma função de T; Por conseguinte, o derivado parcial da capacidade de calor em relação a T é identicamente o mesmo que o derivado completa, obtendo-se por meio de alguma manipulação

Além disso manipulação usando a versão diferencial da lei dos gases ideais, a equação anterior, e assumindo que a pressão constante, encontra-

Por um processo adiabático  e recordando

e recordando  , Encontra-

, Encontra-

Pode-se resolver esta equação diferencial simples de encontrar

Esta equação é conhecido como uma expressão para o constante adiabática, K, também chamado o adiabat. A partir da equação do gás ideal também se sabe

onde  é a constante de Boltzmann. Substituindo na equação acima, juntamente com

é a constante de Boltzmann. Substituindo na equação acima, juntamente com ![V = [gramas] / \ rho](../../images/175/17559.png) e

e  para um gás monoatómico ideal encontra-

para um gás monoatómico ideal encontra-

onde  é o peso molecular médio do gás ou de plasma; e

é o peso molecular médio do gás ou de plasma; e  é a massa do átomo de hidrogénio, o que é muito próximo da massa do protão,

é a massa do átomo de hidrogénio, o que é muito próximo da massa do protão,  , Usou a quantidade mais frequentemente em teoria astrofísica de aglomerados de galáxias. Isto é o que astrofísicos chamam de "entropia" e tem unidades de [keV cm 2]. Esta quantidade se relaciona com a entropia termodinâmico

, Usou a quantidade mais frequentemente em teoria astrofísica de aglomerados de galáxias. Isto é o que astrofísicos chamam de "entropia" e tem unidades de [keV cm 2]. Esta quantidade se relaciona com a entropia termodinâmico

onde  , A densidade de estados em teoria estatística, assume o valor de K, tal como definida acima.

, A densidade de estados em teoria estatística, assume o valor de K, tal como definida acima.

Definições padrão dos manuais

O que se segue é uma lista de definições de entropia de uma coleção de livros didáticos. Note que as definições de livros didáticos não são sempre as definições mais votos, mas eles são um aspecto importante da cultura em torno do conceito de entropia.

- Entropy - energia discriminado em irrecuperável calor .

- Constante vezes de Boltzmann o logaritmo de um multiplicidade; onde a multiplicidade de um macroestado é o número de micro que correspondem ao macroestado.

- O número de maneiras de organizar as coisas em um sistema (os tempos Constante de Boltzmann).

- um termodinâmica não conservada função de estado, medido em termos de número de micro um sistema pode assumir, o que corresponde a uma degradação em utilizável de energia .

- uma medida directa do aleatoriedade de um sistema.

- uma medida de dispersão de energia a uma temperatura específica.

- uma medida da perda parcial da capacidade de um sistema para realizar o trabalho devido aos efeitos de irreversibilidade.

- um índice de a tendência de mudança no sentido de um sistema espontâneo.

- uma medida da indisponibilidade de energia de um sistema para fazer o trabalho; também uma medida da desordem; quanto maior a entropia maior a desordem.

- um parâmetro que representa o estado da desordem de um sistema ao nível atómico, iónica ou molecular.

- uma medida da desordem no universo ou da disponibilidade de energia no sistema para fazer um trabalho.

Abordagens para a compreensão entropia

Ordem e desordem

A entropia, historicamente, tem sido muitas vezes associada com a quantidade de ordem, desordem, e / ou caos em um sistema termodinâmico. A definição tradicional de entropia é que ele se refere a mudanças no status quo do sistema e é uma medida de "desordem molecular" ea quantidade de energia desperdiçada em uma transformação de energia dinâmica de um estado ou forma para outra. Nesse sentido, uma série de autores, nos últimos anos, ter derivado fórmulas exatas de entropia para contabilizar e medir a desordem ea ordem em assembléias atômicas e moleculares. Uma das mais simples fórmulas fim entropia / desordem é que derivado em 1984 pelo físico Peter Landsberg termodinâmico, que se baseia numa combinação de termodinâmica e argumentos teoria da informação. Landsberg argumenta que quando as pressões operar em um sistema, de tal modo que é impedida a entrada de um ou mais dos seus estados possíveis ou permitido, em contraste com os seus estados proibidas, a medida da quantidade total de "desordem" do sistema é dada pela a seguinte expressão:

Do mesmo modo, a quantidade total de "ordem" no sistema é dado por:

Em que C D é a capacidade de "desordem" do sistema, que é a entropia das partes contidas no conjunto permitido, C I é a capacidade de "informação" do sistema, uma expressão semelhante a Shannon a capacidade do canal, e C O é a capacidade de "fim" do sistema.

Dispersão de energia

O conceito de entropia pode ser descrita qualitativamente como uma medida da dispersão de energia a uma temperatura específica. Termos similares têm sido utilizados desde o início da história do termodinâmica clássica , e com o desenvolvimento de termodinâmica estatística e teoria quântica , as mudanças de entropia ter sido descrito em termos de mistura ou "espalhando" da energia total de cada componente de um sistema em relação aos seus níveis de energia quantizada particulares.

Ambigüidades na termos desordem e caos, que geralmente têm significados diretamente opostos ao equilíbrio, contribuir para a confusão generalizada e dificultar a compreensão de entropia para a maioria dos estudantes. À medida que a segunda lei da termodinâmica mostra, em um Sistema Isolado porções internas em diferentes temperaturas tendem a ajustar a uma única temperatura uniforme e, assim, produzir equilíbrio. Uma abordagem educativa desenvolvida recentemente evita termos ambíguos e descreve como se espalhando de energia como a dispersão, o que leva à perda dos diferenciais necessárias para o trabalho, embora a energia total permanece constante, de acordo com a primeira lei da termodinâmica . Físico-químico Peter Atkins, por exemplo, que já escreveu de dispersão levando a um estado desordenado, agora escreve que "mudanças espontâneas são sempre acompanhados por uma dispersão de energia", e descartou "desordem" como uma descrição.

Teoria entropia e informação

Em Teoria da Informação, a entropia é a medida da quantidade de informação que está em falta antes de recepção e é por vezes referida como entropia de Shannon. Shannon entropia é um conceito amplo e geral, que encontra aplicações em teoria, bem como informações termodinâmica. Ele foi originalmente concebido por Claude Shannon em 1948 para estudar a quantidade de informação em uma mensagem transmitida. A definição da entropia de informação é, no entanto, bastante geral, e é expressa em termos de um conjunto discreto de probabilidades  . No caso de mensagens transmitidas, estas probabilidades foram as probabilidades de que uma mensagem em particular foi efectivamente transmitido, e a entropia do sistema de mensagem foi uma medida da quantidade de informação estava na mensagem. Para o caso de probabilidades iguais (ou seja, cada mensagem é igualmente provável), a entropia de Shannon (em bits) é simplesmente o número de perguntas sim / não necessários para determinar o conteúdo da mensagem.

. No caso de mensagens transmitidas, estas probabilidades foram as probabilidades de que uma mensagem em particular foi efectivamente transmitido, e a entropia do sistema de mensagem foi uma medida da quantidade de informação estava na mensagem. Para o caso de probabilidades iguais (ou seja, cada mensagem é igualmente provável), a entropia de Shannon (em bits) é simplesmente o número de perguntas sim / não necessários para determinar o conteúdo da mensagem.

A questão da ligação entre a entropia de informação e entropia termodinâmica é um tema muito debatido. Alguns autores argumentam que há uma ligação entre os dois, enquanto outros argumentam que eles não têm absolutamente nada a ver um com o outro.

As expressões para os dois entropias são muito semelhantes. As informações entropia H para probabilidades iguais  é:

é:

em que K é uma constante que determina as unidades de entropia. Por exemplo, se as unidades são bits, então K = 1 / ln (2). A entropia termodinâmica S, de um ponto de vista estatístico mecânica foi expressa pela primeira vez por Boltzmann:

onde P é a probabilidade de um sistema estar em um micro particular, dado que é em especial um macroestado, e k é a constante de Boltzmann. Pode ser visto que se pode pensar da entropia termodinâmica como a constante de Boltzmann, dividido por ln (2), vezes o número de sim / não perguntas que devem ser feitas, a fim de determinar a microstate do sistema, uma vez que sabemos que a macroestado. A ligação entre a entropia termodinâmica e informações foi desenvolvido em uma série de documentos por Edwin Jaynes começando em 1957.

O problema com ligando entropia termodinâmico à informação que é entropia entropia de informação em todo o corpo da termodinâmica, que lida com a natureza física da entropia está ausente. A segunda lei da termodinâmica, que governa o comportamento de sistemas termodinâmicos em equilíbrio, ea primeira lei que expressa energia térmica como o produto de temperatura e entropia são conceitos físicos, em vez de conceitos informativos. Se a entropia termodinâmica é visto como incluindo todas as dinâmicas físicas de entropia, bem como os aspectos estatística de equilíbrio, então a informação de entropia dá apenas uma parte da descrição da entropia termodinâmica. Alguns autores, como Tom Schneider, argumentam para deixar cair a palavra entropia para a função H da teoria da informação e usar outro termo "incerteza" em vez de Shannon.

Exemplo derretimento do gelo

A ilustração para este artigo é um exemplo clássico em que a entropia aumenta em um pequeno 'universo', um sistema termodinâmico que consiste em 'ambiente' (o quarto quente) e do "sistema" (vidro, gelo, água fria). Neste universo, algum calor δQ energia dos mais quentes entorno quarto (298 K ou 25 ° C) vai espalhar-se para o sistema de refrigeração de gelo e água em sua temperatura T constante de 273 K (0 ° C), a temperatura de fusão de gelo. A entropia do sistema altera-se por a quantidade ds = δQ / T, neste exemplo δQ / 273 K. (O δQ calor para este processo é a energia necessária para mudar a água a partir do estado sólido para o estado líquido, e é chamada o entalpia de fusão, isto é, a ΔH. para a fusão do gelo) a entropia do ambiente vai mudar de um montantedS= -δQ/ 298 K. Assim, neste exemplo, a entropia do sistema aumenta, ao passo que a entropia do ambiente diminui .

É importante perceber que a diminuição na entropia do ambiente circundante é menor do que o aumento da entropia do gelo e água: a temperatura ambiente de 298 K é superior a 273 K e, por conseguinte, a relação, (variação de entropia), de δQ / 298 K para o ambiente é menor do que a relação (variação de entropia), de δQ / 273 K para o sistema de gelo + água. Para encontrar a variação de entropia do nosso "universo", somarmos as variações de entropia para seus componentes: o quarto ao redor, eo gelo + água. A mudança total entropia é positiva; este é sempre verdadeiro em eventos espontâneos em um sistema termodinâmico e mostra a importância preditivo de entropia: a entropia líquido final após tal evento é sempre maior do que era a entropia inicial.

À medida que a temperatura da água fresca sobe para a do ambiente e o quarto mais arrefece imperceptivelmente, a soma do δQ / T ao longo da gama contínua, em muitos incrementos, no inicialmente frio para, finalmente, a água quente pode ser encontrado por cálculo. A inteira em miniatura "universo", ou seja, este sistema termodinâmico, aumentou em entropia. Energia tornou-se espontaneamente mais dispersa e espalhar-se pelo facto de "universo" do que quando o copo de água gelada foi introduzida e tornou-se um "sistema" dentro dele.

Tópicos em entropia

Entropia e vida

Por mais de um século e meio, começando com Clausius 1863 memoir "Na concentração de raios de calor e luz, e sobre os limites de sua atuação", muita escrita e de investigação tem sido dedicada à relação entre a entropia termodinâmica ea evolução de vida . O argumento de que a vida se alimenta de entropia negativa ou neguentropia que propõe no livro 1944 O que é vida? por físico Erwin Schrödinger serviu como mais um estímulo a esta pesquisa. Escritos recentes têm utilizado o conceito de energia livre de Gibbs para a reflexão sobre esta questão. Tangencialmente, alguns criacionistas têm argumentado que a entropia exclui evolução .

Nos populares 1.982 livros didáticos Princípios de Bioquímica pelo bioquímico americano notável Albert Lehninger, por exemplo, argumenta-se que a ordem produzida dentro das células como eles crescem e se dividem é mais do que compensada pelo transtorno que eles criam em seus arredores no curso de crescimento e divisão. Em suma, de acordo com Lehninger, "organismos vivos preservar a sua ordem interna, tomando de seus arredores energia livre, na forma de nutrientes ou luz solar, e retornar ao seu ambiente uma quantidade igual de energia como calor e entropia. "

Evolução relacionada definições:

- Neguentropia- uma frase coloquial abreviação para entropia negativa.

- Ectropy- uma medida da tendência de um sistema dinâmico para fazer o trabalho útil e crescer mais organizada.

- Sintropia- uma tendência para a ordem e combinações simétricas e desenhos de padrões cada vez mais vantajosas e ordenadas.

- Extropy- um termo metafórico definir a extensão de uma vida ou a inteligência do sistema organizacional, ordem funcional, vitalidade, energia, vida, experiência e capacidade e unidade para a melhoria e crescimento.

- Entropia ecológica- uma medida dabiodiversidadeno estudo do biológicoecologia.

A seta do tempo

Entropia é a única quantidade nas ciências físicas "picaretas" que uma determinada direção para o tempo, às vezes chamado de flecha do tempo. À medida que avançamos "forward" com o tempo, a Segunda Lei da Termodinâmica diz-nos que a entropia de um sistema isolado só pode aumentar ou permanecer a mesma; ele não pode diminuir. Assim, a partir de uma perspectiva, a medição entropia é considerada como um tipo de relógio.

Entropia e cosmologia

Como um universo finito pode ser considerado um sistema isolado, pode ser sujeita à segunda lei da termodinâmica, de modo que a sua entropia total está aumentando constantemente. Tem sido especulado que o universo está destinado a uma morte pelo calor em que toda a energia termina como uma distribuição homogénea de energia térmica, de modo a que não mais de trabalho pode ser extraído a partir de qualquer fonte.

Se o universo pode ser considerado como tendo geralmente entropia crescente, então - como Roger Penrose apontou - a gravidade desempenha um papel importante no aumento porque a gravidade faz com que a matéria dispersa a acumular-se em estrelas, que eventualmente colapso em buracos negros . Jacob Bekenstein e Stephen Hawking têm mostrado que os buracos negros tem a entropia máxima possível de qualquer objecto de igual tamanho. Isto torna-os susceptíveis pontos finais de todos os processos de aumento da entropia, se eles são armadilhas matéria e energia totalmente eficazes. Hawking, no entanto, mudou recentemente sua posição sobre este aspecto.

O papel da entropia na cosmologia permanece um assunto controverso. Um trabalho recente tem elenco extenso em dúvida a hipótese de morte do calor e da aplicabilidade de qualquer modelo termodinâmico simples para o universo em geral. Embora entropia faz aumento no modelo de um universo em expansão, a entropia máxima possível sobe muito mais rapidamente - assim a densidade de entropia está diminuindo com o tempo. Isso resulta em uma "lacuna entropia" empurrando o sistema mais longe do equilíbrio. Outros fatores complicadores, como a densidade de energia do vácuo e macroscópicas quântica efeitos, são difíceis de conciliar com os modelos termodinâmicos, fazer qualquer previsão da termodinâmica de grande escala extremamente difícil.

Outras relações

Outras definições matemáticas

- Kolmogorov-Sinai entropia- um tipo de matemática da entropia emsistemas dinâmicos relacionados com as medidas de partições.

- Entropia topológica- uma maneira de definir a entropia em um mapa função de iteração de teoria ergódica.

- Entropia relativa- é uma medida de distância natural a partir de uma distribuição de probabilidade "true"Pa um arbitrária distribuição de probabilidadeQ.

- Entropia Rényi- uma medida de entropia generalizada de sistemas de fractais.

Definições sociológicas

O conceito de entropia também entrou no domínio dasociologia, geralmente como umametáfora para o caos, desordem ou dissipação de energia, e não como uma medida direta da entropia termodinâmica ou informações:

- Entropology- o estudo ou discussão de entropia ou o nome dado às vezes atermodinâmicasemequações diferenciais.

- Entropia psicológica- a distribuição de energia na psique, que tende a buscar o equilíbrio ou equilíbrio entre todas as estruturas da psique.

- Entropia econômica- uma medida semi-quantitativa da dissipação irrevogável e degradação de materiais naturais e de energia disponíveis no que diz respeito à actividade económica.

- Entropia social - uma medida da estrutura de sistema social, tendo ambas as interpretações teóricas e estatísticos, ou seja, a sociedade (variáveis macrosocietal) medido em termos de como as funções individuais na sociedade (variáveis microsocietal); também relacionado ao equilíbrio social.

- Entropia empresarial - o desperdício de energia como burocracia e ineficiência da equipe de negócios, ou seja, energia perdida para o lixo. (Esta definição é comparável ao conceito de von Clausewitz do atrito na guerra.)

Cotações

| " | Qualquer método que envolve a noção deentropia, a própria existência dos quais depende asegunda lei da termodinâmica, irá sem dúvida parecer a muitos rebuscado, e pode repelir iniciantes como obscuro e difícil de compreensão. | " |

- -Willard Gibbs,gráficos Métodos no Termodinâmica de Fluidos(1873)

| " | Minha maior preocupação era como chamá-la. Pensei em chamá-lo de "informação", mas a palavra foi usada excessivamente, então eu decidi chamá-lo de 'incerteza'. Quando discuti-lo com John von Neumann , ele teve uma idéia melhor. Von Neumann me disse: 'Você deve chamá-lo de entropia , por duas razões. Em primeiro lugar a sua função de incerteza tem sido utilizada em mecânica estatística sob esse nome, por isso já tem um nome. Em segundo lugar, e mais importante, ninguém sabe o que realmente é entropia, assim, em um debate que você terá sempre a vantagem. | " |

- --Conversation EntreClaude Shannon eJohn von Neumannsobre que nome dar à "medida da incerteza" ou atenuação de sinais de linha de telefone (1949)

| " | Cada estrela que queima, cada planeta cuja órbita está lentamente se deteriorando, cada respiração e calorias você metabolizar traz o universo para mais perto e mais perto do ponto em que a entropia é maximizada, movimento organizado de qualquer tipo cessa, e nunca acontece nada de novo. Não há como escapar. Não importa o quão magnífico vida no universo torna-se ou como avançado, o lento aumento na entropia não pode ser interrompido - o universo acabará por morrer. | " |

- --Warren Friedl, da Universidade de Windsor (2007)